Réalité augmentée : quelles possibilités aujourd’hui ?

D’abord, pour comprendre les nouvelles possibilités de la réalité augmentée, il faut comprendre quelles étaient ses limites.

La réalité augmentée fonctionne sur la reconnaissance du réel. Nous expliquions ça dans nos premiers articles sur le sujet.

La reconnaissance du réel, ça ne veut pas dire qu’elle reconnaît tout ce qui se présente à elle, mais plutôt qu’elle a besoin d’un référent réel pour oeuvrer. Un référent qu’on lui a appris à reconnaître, qui va non seulement lui donner le signal pour afficher le contenu, et qui va aussi lui permettre de le superposer correctement dans l’espace.

Car s’il n’y a rien de plus simple que d’afficher un Pikachu sur son écran, il est plus compliqué de le placer correctement dans l’environnement.

C’est pour cette raison, que l’image-marqueur a longtemps été privilégiée par les développeurs. D’abord parce qu’elle constitue un élément facile à mémoriser pour l’application, et aussi parce qu’on peut la placer dans le décor et offrir un référentiel spatial.

Et si les développeurs se sont longtemps arrangés avec ça pour créer leurs outils, ils souhaitaient toutefois aller vers une réalité augmentée plus libre. En 2017, Apple a répondu à cet appel en lançant l’ARkit. Aussitôt talonnée par Google qui a lancé son ARcore. Ce fût pour les développeurs une mise à disposition d’outils prometteurs.

Extension du tracking au monde environnant

La réalité augmentée a vu son tracking s’étendre au monde environnant. Ce qui signifie que lorsque vous filmez avec votre appareil, l’application voit le monde qui l’entoure.

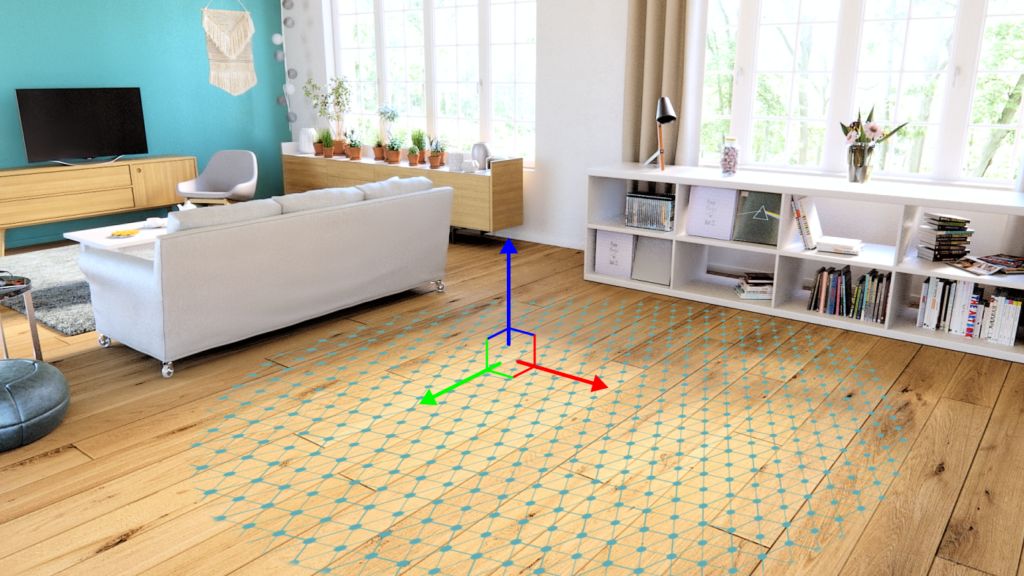

Non seulement elle le voit, mais elle le cartographie. Elle crée sa propre worldmap, une carte de l’environnement immédiat. Ce qu’elle voit, ce sont des plans : sol, mur, table, meuble. Une carte des surfaces sur lesquelles l’application va poser l’objet 3D.

Pour accomplir cet exploit, les applications sollicitent les capacités de votre smartphone.

l’ARkit de Apple utilise la caméra dont elle analyse le flux RGB – les couleurs donc. Tandis que l’ARCore exploite le capteur infrarouge de votre smartphone comme avec un lidar, et en tire un nuage de points – on parle de cloud anchors – qui met en évidence les surfaces de l’environnement.

Exactement comme nos sens (notamment la vue et le sens vestibulaire), l’appareil mêle différentes informations pour comprendre son monde. Ce qui, en passant, lui permet également de tenir compte de la lumière dans l’affichage du contenu.

Prenons alors un exemple concret : la décoration d’une pièce avec un meuble numérique. Là où auparavant une image-marqueur était indispensable pour faire apparaître le meuble dans votre pièce – vous posiez un QRcode au sol, et vous le filmiez – aujourd’hui, vous pouvez choisir ce même meuble dans un catalogue numérique et le placer directement dans votre pièce.

Une réalité augmentée plus solide

Cette worldmap sert aussi à assoir le contenu solidement.

En enregistrant une carte du monde, l’application enregistre ce qu’elle place dedans. Elle connaît à la fois la position de l’utilisateur et la position de l’objet numérique. Ce qui permet alors de ne pas perdre le contenu, même lorsqu’on le perd de vue.

Si bien que, pour reprendre notre exemple des meubles, on peut placer plusieurs objets 3D dans une pièce sans en perdre aucun. Placer un placard ici, un sofa là, un fauteuil là-bas, et habiller numériquement une pièce de cette façon. Bien sûr, ce qui vaut pour des meubles, vaut pour tout autre objet numérique.

D’abord la possibilité de sauvegarder la position du contenu en conservant la worldmap. On parle alors de persistance de la worldmap. Ce qui signifie que si vous posez un objet virtuel, que vous éteignez votre tablette, puis la rallumez, vous retrouvez l’objet au même endroit.

Enfin, le partage entre plusieurs devices qui permet d’afficher du contenu et d’interagir avec depuis deux appareils. Car si l’application sait conserver des informations de position, elle est aussi capable de les partager.

Extension du tracking aux objets

Autre nouveauté intéressante : la possibilité de se servir d’objets comme marqueurs, et donc d’augmenter ces objets. Bien évidemment, il y a objet et objet. Augmenter une figurine, oui. Augmenter un boeing 747, non.

Il s’agira d’apprendre à l’application à reconnaître des petits objets, de la même manière qu’elle apprend à distinguer des images, ou à reconnaître la présence de visages. Bien plus qu’une fonction accessoire, c’est une ouverture des possibilités pour bien des domaines, comme celui du retail par exemple. On peut customiser des meubles, des vêtements, des voitures, décliner différents coloris, différentes gammes, augmenter des pièces de musée, habiller des jouets, etc.

En revanche, la solution connaît ses limites lorsqu’il s’agit de reconnaître des objets aux formes standards comme on en trouve dans le commerce. En effet, comment faire la différence entre deux boîtes de céréales qui ont exactement la même forme ? Eh bien, on fera appel à la bonne vieille reconnaissance d’images. C’est l’illustration du packaging qui servira de support à l’application.

On notera alors que l’image-marqueur n’a pas été bannie de la réalité augmentée, mais qu’elle peut venir renforcer l’expérience, et compléter ses failles en étant conjuguée à la worldmap. La réalité augmentée ne s’est pas transformée, elle s’est seulement enrichie.

Vers quelles améliorations se dirige-t-on ?

On se doute bien que la technologie va encore évoluer, et on peut déjà deviner vers quelles améliorations elle se dirige.

D’abord vers une reconnaissance du réel toujours plus performante. Pour cela, il s’agira d’améliorer à la fois l’hardware et le software. Il est probable qu’à l’avenir, nos appareils soient dotés de meilleurs capteurs, de meilleurs outils pour cueillir les informations, et que les logiciels réussissent à traiter de mieux en mieux ces informations, notamment grâce aux avancées faites dans le deep learning.

Si aujourd’hui, nos appareils sont capables de reconnaître ce qu’ils connaissent déjà, demain ils seront capables de reconnaître l’environnement par eux-mêmes, d’emmagasiner des informations conséquentes et de les restituer en temps réel.

Car croiser une multiplicité d’informations a toujours été la recette de la réalité augmentée. Nos applications utilisent tout ce qu’elles peuvents pour se situer dans le monde. Et tout indique qu’à l’avenir, elles ne se contentent plus seulement de quelques données immédiates mais aillent puiser des ensembles massifs de données – le fameux big data.

Et c’est déjà le cas pour certaines applications. On pensera à l’outil AR de Google Maps qui croise les données GPS de l’appareil et toutes les informations d’images street view pour guider les usagers directement à travers leurs écrans.

Qui n’a jamais rêvé d’un GPS qui viendrait se superposer au réel ?

La réalité mixte de demain : Google Glass 2 et Hololens 2

Mais l’avenir appartient surtout à la réalité mixte qui cherche à affranchir la réalité augmentée de la barrière de l’écran. Le rêve ultime, c’est l’hologramme. Et aujourd’hui, la technologie permet de s’en approcher.