Comment fonctionne la réalité mixte ?

Les technologies de base

Du head tracking pour suivre la tête

Des caméras pour reconnaître l’environnement

Tous ces yeux fixés sur nos casques ont un but

Ce système de mapping est directement emprunté à la réalité augmentée

Et plus particulièrement aux dernières technologies R.A dont nous parlions dans cet article. Des technologies qui ont fait avancer la R.A vers plus de liberté en permettant :

- De poser des hologrammes sans utiliser des marqueurs, et donc de les disposer dans n’importe quel espace.

- De reconnaître des objets précis pour les augmenter.

La réalité mixte reprend ces technologies à son compte et les intègre dans les casques. Sauf que voilà…

Faire de la réalité augmentée sous un casque ne suffit pas à produire de la réalité mixte. Le mariage entre R.A et V.R n’est pas si simple à opérer. Il fait sourdre des problématiques nouvelles d’ergonomie et de fonctionnement. Par exemple : comment conserver une lecture claire de l’environnement si on décide d’enfermer l’utilisateur sous un casque ? Cette question en entraîne une autre, plus importante encore.

Comment décide-t-on de montrer le monde ?

Deux façons de faire de la réalité mixte

Pour répondre à cette question, les constructeurs proposent aujourd’hui deux solutions.- Montrer le monde de manière directe. C’est le cas des casques Hololens ou Magic Leap qui laissent voir le monde à travers des lunettes.

- Le montrer de manière indirecte. Choix que font les fabricants de réalité virtuelle dont les derniers casques font aussi de la réalité mixte.

Méthode classique : voir le monde à travers des lunettes

Le rôle des waveguides : guider la lumière pour créer l’illusion

Mais ces dispositifs ont un défaut

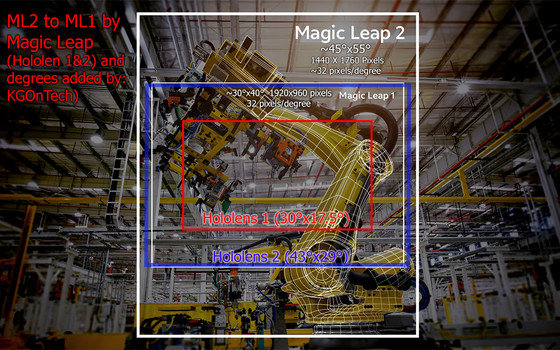

Étant placés comme des filtres sur les verres, les guides d’ondes forment des fenêtres à travers lesquelles nos yeux sont forcés de regarder s’ils veulent voir les hologrammes. L’image n’est pas envoyée n’importe où sur le verre, elle est envoyée sur eux uniquement. Résultat : notre champ de vision holographique est réduit.

- Disposer plusieurs guides d’ondes sur le verre, donc plusieurs fenêtres d’observation. C’est ce que fait la société Digilens par exemple avec ses lunettes ARGO.

- Ou offrir un seul filtre sur l’ensemble du verre, mais avec un verre lui-même réduit. Ce que fait Magic Leap.

Bref ! Une bataille est en cours pour savoir qui obtiendra le meilleur FOV (champ de vision). À ce jour, c’est le Magic Leap 2 qui l’emporte. Demain ce sera peut-être un autre fabricant. Les paris sont ouverts.

Ce FOV réduit est souvent une mauvaise surprise pour le consommateur. Lui qui pensait que les lunettes garantissaient un angle de vue total, découvre que les hologrammes ne sont pas observables en périphérie de son regard.

L’opacité de l’hologramme : un axe d’amélioration

Avec les lunettes XR, les hologrammes ont toujours été un peu transparents. Normal, ils sont des reflets sur des verres, leur transparence est inévitable – et la lumière d’une pièce ou du soleil nuit à la luminosité des hologrammes.

Ce défaut a vite été compris par les concurrents qui ont vanté dans leur méthode l’aspect tangible de leurs hologrammes.

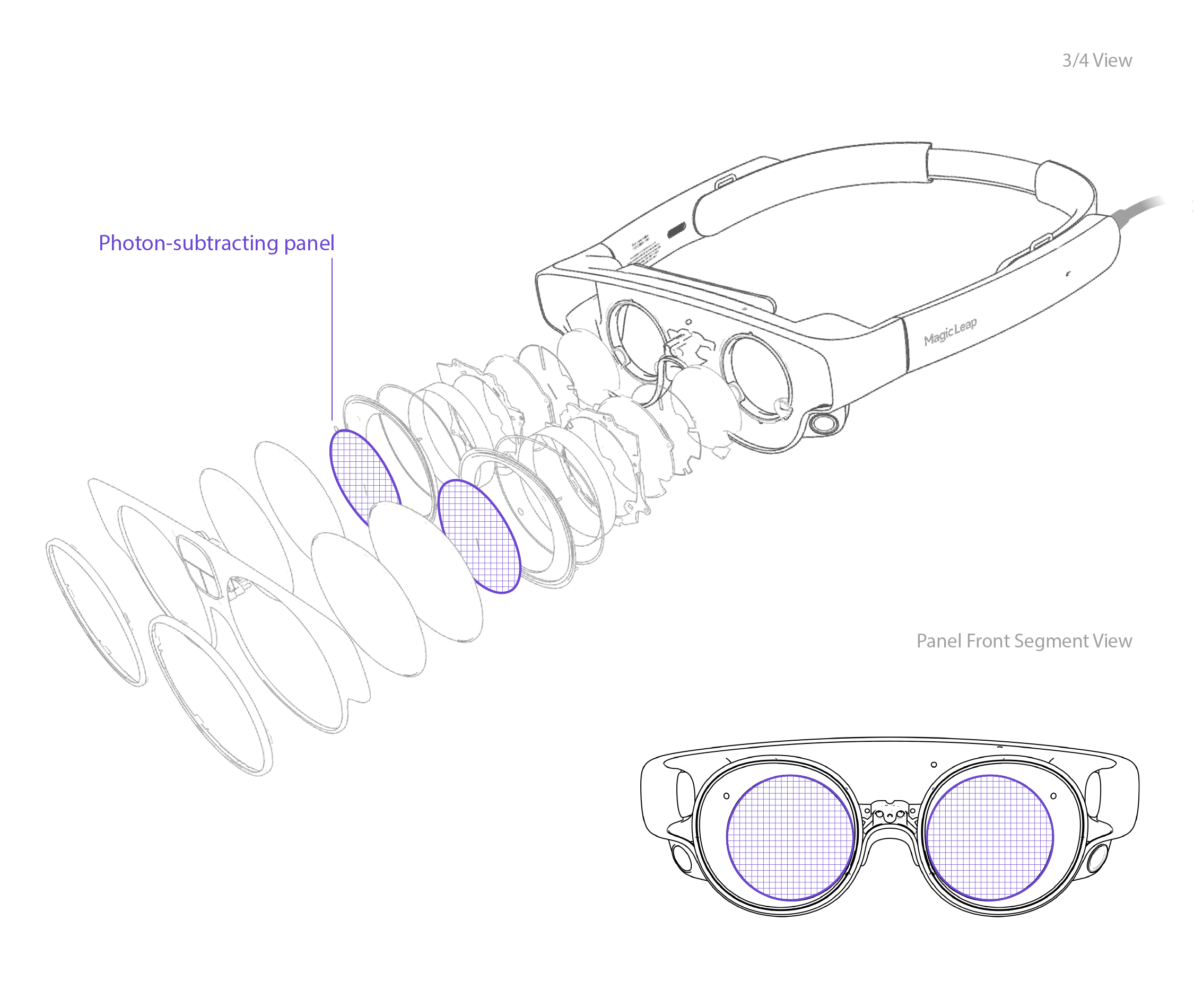

Ni une ni deux, Magic Leap s’est emparé du problème et y a répondu dans ses dernières lunettes avec une option appelée segmented dimming (gradation segmentée) et une autre appelée global dimming (gradation globale). Les deux permettent respectivement d’opacifier l’hologramme et d’opacifier le monde.

Opacifier l’hologramme pour le rendre plus réel. Opacifier le monde pour les mêmes raisons, mais surtout pour pouvoir utiliser le casque en extérieur sans être gêné par la lumière du soleil. Derrière cette fonctionnalité il y a une innovation matérielle. Les lunettes du Magic Leap 2 sont en fait des couches successives de verres (une dizaine de couches !) qui forment des écrans additifs.

Méthode passthrough : voir le monde à travers des écrans

De leur côté, les sociétés comme Oculus ou HTC se lancent aussi dans la réalité mixte, sans toutefois abandonner la réalité virtuelle. Ce qu’elles veulent, c’est faire les deux à la fois sous un même casque. Pour cela, elles ont trouvé l’astuce : montrer le monde grâce aux caméras.

C’est la méthode du « passthrough ». Les caméras filment l’environnement et transmettent l’image aux écrans. La personne regarde son monde de manière indirecte à travers les écrans, les hologrammes viennent ensuite se superposer à son image. De la réalité augmentée sous un casque quoi !

Non justement, pas tout à fait. C’est plus complexe que ça.

Nous observons une image recomposée

Les casques ne retranscrivent pas l’image telle quelle. Ils recomposent une nouvelle image. Le terme pass-through (passer au travers) est donc un peu trompeur, car en pratique l’image n’est pas transmise directement de la caméra à l’écran. Elle suit un processus compliqué de recomposition pour offrir une image qui serait celle de l’utilisateur si ce dernier n’avait pas d’écran devant les yeux. En clair : le passthrough recrée le point de vue de l’utilisateur plutôt que de conserver le point du vue du casque.

Ce procédé est indispensable pour aboutir à une expérience confortable, sans quoi nous verrions le monde en décalé, sans parallaxe, et avec un léger retard sur nos mouvements.

Pour effectuer ce recalcul, les casques exploitent justement les données des caméras RVB et infrarouges (les fameuses). C’est du moins ce qu’explique Andrew Bosworth, directeur technique de Meta, à propos de son Meta Quest 2. L’image calculée est ainsi capable de :

- Retranscrire la parallaxe.

- Retranscrire l’espace colorimétrique.

- Recaler la position de l’image comme si elle était à hauteur de nos yeux.

La chose est marrante quand on y pense. Les fabricants sont obligés d’élaborer des systèmes complexes pour reproduire dans leurs casques le regard dont ils nous privent …avec leurs casques.

La méthode passthrough est l’exact inverse de la méthode Hololens.

L’hololens arrive facilement à montrer le monde, mais doit ruser pour afficher des hologrammes.

Le passthrough arrive facilement à afficher des hologrammes, mais doit ruser pour montrer le monde. Aujourd’hui la méthode n’est pas parfaite. Elle ne suffit pas à créer une expérience totalement confortable. Difficile d’être 100% confiant et de se déplacer comme si on n’avait rien sur la tête lorsqu’on a justement quelque chose sur la tête. On adopte automatiquement une méticulosité dans nos mouvements.

L’idéal serait d’avoir une vue-écran qui parvienne à nous leurrer complètement. Une vue qui imite tellement bien notre regard, qu’on en vienne à croire qu’il n’y a pas d’écran, et que l’on regarde à travers une visière.

Les technologies spécifiques à la réalité mixte

Du tracking, du tracking et du tracking encore

Nous avons commencé cet article en parlant de technologies qui concernent les dispositifs immersifs dans leur intégralité. Le head tracking la reconnaissance d’environnement ont été empruntés à la réalité virtuelle et la réalité augmentée.

Entrons maintenant dans le dur.

Abordons les technologies implémentées pour des besoins spécifiques à la réalité mixte. Des technos qui concernent d’ailleurs les deux types de casques que l’on vient de voir – classique et passthrough – car leur rôle est de créer une interaction toujours plus riche et naturelle entre l’utilisateur et le virtuel.

Car voyez-vous, la réalité mixte vise un idéal. Cet idéal c’est Minority Report. On rêve de pouvoir contrôler des objets virtuels flottant autour de nous. On voudrait un virtuel qui réponde à tous nos gestes, de manière lisible, crédible et intuitive.

Pour essayer d’atteindre ce rêve, les constructeurs comprennent alors qu’il faut capter le moindre de nos mouvements. Aucune interaction n’est possible sans cela. Et pour ça, il n’y a pas de secret : il faut tracker, tracker et tracker encore. C’est donc reparti pour du tracking.

Eye tracking : suivre les yeux pour faire…plein de choses

La documentation Hololens dit ceci :

« des caméras situées près du nez permettent de suivre le regard mais aussi d’adapter l’affichage à l’écart pupillaire de chacun. Le support windows hello permet de reconnaitre l’utilisateur grâce à ses pupilles ».

Tout est dit en deux phrases, ou presque. Les casques embarquent en effet des systèmes d’eye tracking capables de suivre notre regard et d’en tirer plusieurs choses.

Nous n’essaierons pas ici d’expliquer comment la technologie fonctionne en détail. En revanche, il est intéressant de comprendre d’où elle vient pour en comprendre ses usages.

Rapide historique de l’eye tracking

Contrairement à ce qu’on croit, l’eye tracking n’est pas nouveau. Les premiers systèmes capables d’enregistrer les mouvements oculaires datent des années 50. On l’utilisait essentiellement pour mener des études comportementales – ce qu’on appelle l’oculométrie cognitive. L’oculométrie est une science plus ancienne encore, mais c’est à partir de ces années-là qu’elle fait intervenir des systèmes de tracking non invasifs. C’est-à-dire des appareils qui observent nos yeux sans y toucher et reconnaissent leurs micromouvements : position, fixation, saut, balayage, etc.

Ensuite, d’outil d’analyse, il est devenu un outil d’interface homme-machine à partir des années 80. C’est-à-dire un outil qui fait de nos yeux des contrôleurs. Destiné au départ aux personnes handicapées pour leur permettre de communiquer par le regard, les premiers systèmes – comme le Eye tracker communication system datant de 1981 – ont ensuite été perfectionnés, sont passés dans nos PC, dans nos smartphones, ont été expérimentés dans le jeu vidéo, avant d’atterrir aujourd’hui dans nos casques.

L’eye tracking a donc deux utilités : l’analyse et le contrôle. Ce sont ces deux mêmes rôles qu’il joue dans les casques XR.

L’analyse : observer nos yeux pour créer du confort

L’eye tracking sert d’abord un souci de confort, priorité des priorités lorsqu’on veut démocratiser une technologie.

Les casques prennent en compte l’écart interpupillaire pour régler l’effet de profondeur de l’hologramme (le relief repose en effet sur l’écart des yeux). Le suivi oculaire oblige d’ailleurs chaque nouvel utilisateur à procéder à un étalonnage quand il met le casque pour la première fois.

En suivant notre regard, les casques procèdent aussi à ce qu’on appelle un rendu fovéal. C’est-à-dire un rendu plus précis de l’image là où notre regard porte. Technique très utilisée en jeu vidéo, elle ne permet pas seulement d’obtenir une image plus précise, mais aussi d’optimiser le calcul de manière générale.

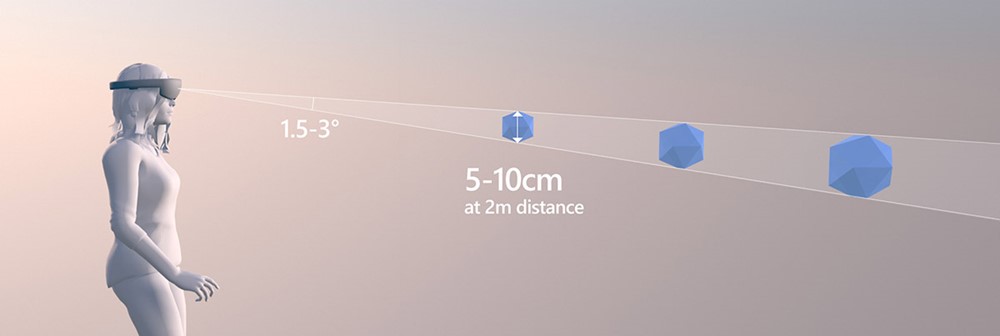

Mais le confort se travaille aussi sur l’hologramme lui-même. La documentation d’Hololens donne un ensemble de conseils aux développeurs pour bien les placer et créer du feedback intelligent. Par exemple il est recommandé de les rapprocher à deux mètres au plus près et de respecter des consignes de taille pour une meilleure lisibilité. Hololens invite aussi les développeurs à créer du feedback implicite : défilement automatique basé sur les yeux, zoom panoramique, hologrammes attentifs.

L’Eye Tracking accompagne les devs dans cette mission en leur fournissant un ensemble d’informations dont ils peuvent tirer parti. Des informations sur la direction du regard, l’attention, la vergence des yeux, l’accommodation, etc… Elles permettront de mesurer l’efficacité de l’UX afin de l’améliorer. Elles pourront aussi être utilisées dans des études de recherche, des évaluations de conception marketing, et des surveillances de performance.

Bref, exactement les mêmes usages qu’en oculométrie cognitive, car au fond c’est exactement de cela dont il s’agit. (Toutes ces informations sont à retrouver dans la documentation Hololens 2, partie « design eye tracking.)

Le contrôle : utiliser nos yeux pour commander les hologrammes.

Ce suivi permet ensuite de donner le contrôle à nos yeux.

Si les fabricants tiennent tant à faire de ces derniers des périphériques informatiques, ce n’est pas pour rien. Leurs raisons sont solides.

Ce faisant, les bras peuvent se reposer et les utilisateurs mener des sessions moins fatigantes. Nos yeux peuvent sélectionner des hologrammes, naviguer dans l’interface, valider des contenus, ou encore faire défiler des textes sans aucun geste. Argument intéressant pour ceux dont le casque est un outil de travail.

Pour rendre la navigation plus souple, les yeux sont souvent couplés à autre chose. Sous Hololens par exemple on peut viser un hologramme et le saisir en disant « sélectionner ». Voix et yeux travaillent ensemble. Mais ce peut être aussi un couple yeux-mains grâce au hand tracking.

La deuxième raison, c’est que l’œil est le muscle le plus performant qui existe. Il n’y a aucun curseur plus rapide et précis que lui. Naviguer dans une interface au regard, c’est pouvoir passer d’un élément à l’autre en une fraction de seconde, sans avoir à doser le geste. Les yeux ne savent pas mal viser. Mais encore faut-il pouvoir leur obéir. Le vrai défi aujourd’hui n’est pas tant de savoir comment transformer nos yeux en contrôleurs – ça, nous savons le faire – mais comment saisir des stimuli toujours plus fins pour gagner en précision et concevoir des systèmes capables de suivre l’ultra-performance de nos yeux.

À l’heure actuelle, ce qu’on appelle le « gaze input » est encore à perfectionner. On sait où regarde la personne, mais une marge d’imprécision existe que Microsoft recommande de prendre en compte. Les conseils d’affichage dont nous parlions plus haut sont en partie liés à ça.

Hand et Face tracking

Après la tête et les yeux, ne restent plus que le visage et les mains. Ça tombe bien, leur suivi a été intégré dans les derniers casques.Face Tracking : retranscrire nos expressions faciales

Aujourd’hui le Face Tracking sert essentiellement aux applications sociales et à quelques jeux vidéo, chez Meta Quest Pro par exemple, il permet de retranscrire nos expressions faciales sur le visage de notre avatar.

Sur internet, vous croiserez donc beaucoup de vidéos de réunions virtuelles dans lesquelles des amis expriment physiquement leur joie sur le visage de leur double virtuel.

La même chose est possible non plus en VR mais en réalité mixte. On peut aujourd’hui voir nos amis ou nos collègues dans notre salon et mener des discussions avec eux. Le suivi du visage offre des interactions humaines plus poussées que ne le permettaient les anciens casques. Les capteurs lisent tout : bouche, yeux, sourcils, muscles faciaux. La qualité est assez bluffante.

Pour capter tout cela, des caméras discrètes sont embarquées à l’intérieur de la visière en direction du visage. Un espace est donc prévu pour les caméras. Le Meta Quest Pro n’isole pas nos yeux, la lumière peut y pénétrer ce qui peut nuire à l’immersion.

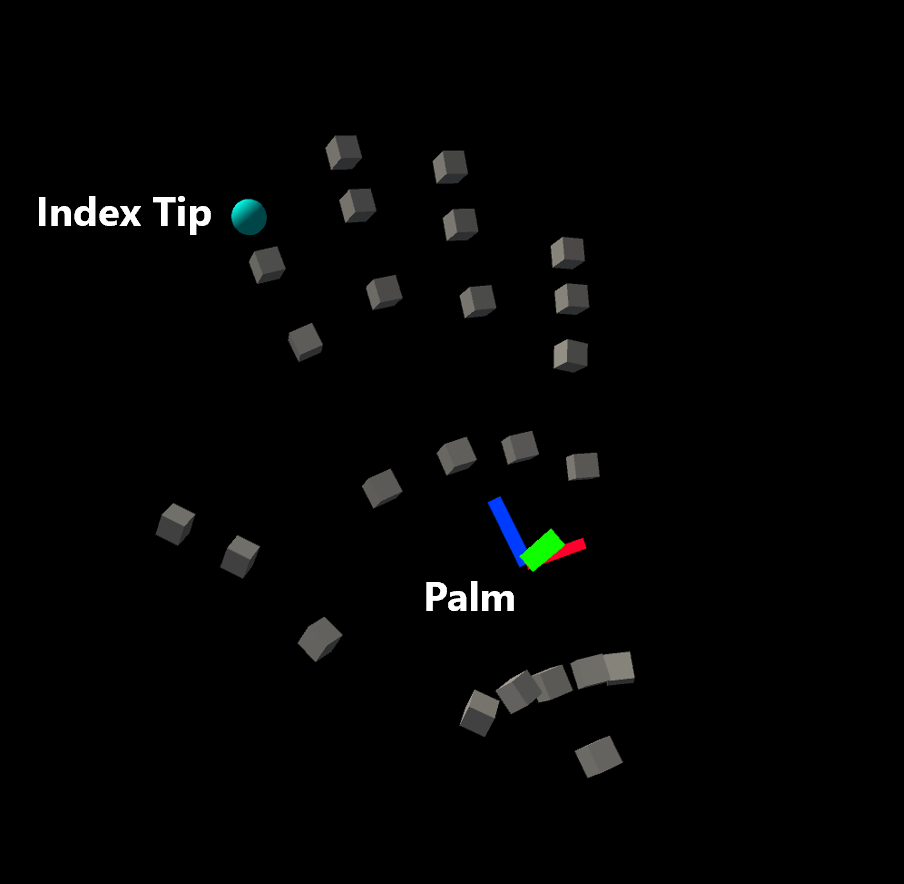

Hand Tracking : toucher ce qui est intouchable

Quant au Hand Tracking, il existe depuis plusieurs années déjà dans les casques. Le premier Hololens en avait, l’Oculus Quest aussi. Son but est évident : permettre aux usagers de manipuler des hologrammes manuellement, qu’ils soient des objets 3D ou des interfaces.

À la question « comment tout cela marche techniquement ? », nous choisirons une réponse brève : ça marche comme le reste. Côté hardware, ce sont toujours les mêmes caméras RGB-D qui regardent nos mains. Côté software l’Hololens embarque un kit d’outils MRTK (Mixed Reality Toolkit) qui comprend le suivi des mains. Ce n’est donc pas un défi. On a les outils compétents pour.

Comme toujours, le défi est ailleurs. Ici il est double :

- Concevoir des API capables de distinguer des gestes toujours plus fins.

- Élaborer un panel de gestes qui soient riches, mais toujours intuitifs pour l’utilisateur.

Et c’est peut-être ce deuxième point qui est le plus complexe. Interagir avec des hologrammes oblige à créer un nouveau langage homme-machine.

D’abord parce qu’on manipule de l’immatériel. On ne se doute pas à quel point l’absence de tactile pose problème. On ne touche rien, on interagit avec des objets qui n’en sont pas, et dont les distances sont factices. Ce ne sont que des foutues des projections face à l’œil !

Aussi parce que ces objets sont en volume, et que le volume ajoute des interactions qui n’existent pas avec les interfaces plates. Ne serait-ce que pour bouger un objet dans ses différents axes X-Y-Z. Cela rapproche presque l’usager de l’infographiste 3D. Et croyez-nous, on sait de quoi on parle.

Tout cela ensemble soulève plein de questions.

En réalité mixte manuelle, comment différencier un geste de validation d’un geste de saisi ? Et une fois l’hologramme saisi, comment distinguer un geste de déplacement d’un geste de rotation ?

Si on se penche sur les solutions imaginées par Hololens et Magic Leap, on découvre qu’ils envisagent de la même manière ce langage. Magic Leap reconnaît huit poses de main. Hololens en reconnaît un peu moins et ne conserve que des gestes intuitifs – des gestes simples comme touch, hand ray, ou air tap.

On découvre aussi que les deux choisissent de ne pas se reposer uniquement sur ces gestes, mais d’ajouter des options activables sur les hologrammes, entraînant une richesse de manipulation bienvenue. En démonstration ici.

Tout cela rend évidemment la manipulation d’hologramme compliquée pour celui qui s’y essaie la première fois. Un apprentissage est nécessaire, mais il est d’autant plus normal que les casques sont pensés comme des outils de travail. C’est leur devoir d’être le plus simple possible, mais c’est aussi leur devoir d’inclure beaucoup de possibilités afin que l’ingénieur, le chirurgien ou le cadre puisse s’aménager son espace virtuel sur mesure et sa propre organisation sans être bridé par l’outil.

Concluons et résumons

Voilà, nous arrivons au bout de ce dépiautage des casques. C’était long ? Nous nous sommes pourtant restreints aux technologies principales, celles qui importent vraiment pour comprendre ce que la réalité mixte peut faire. Récapitulons alors. La réalité mixte permet de :

- Suivre la position et les mouvements d’une personne

- Voir le monde, y asseoir les hologrammes, les rendre persistants et occultables, bref : crédibles.

Il existe deux voies aujourd’hui pour les acteurs du marché :

- La réalité mixte classique qui nous laisse voir le monde à travers des lunettes

- La méthode passthrough qui l’affiche sur des écrans.

Les deux ont leurs qualités et leurs faiblesses, mais l’innovation va vite dans ce monde-là.

Les casques sont ensuite bardés de modules de tracking permettant de confondre toujours mieux le réel au virtuel. Désormais nos yeux, nos bras, notre voix sont utilisables pour interagir avec les hologrammes.

Maintenant que nous savons tout cela, nous pouvons répondre plus facilement à la vraie question qui nous intéresse : mais quel casque choisir alors ?! Pour cela, rendez-vous à l’article suivant.