Réalité mixte, que valent les casques passthrough ? (partie 3)

Réalité mixte, que valent les casques passthrough ?

Troisième et dernière partie de notre article sur la réalité mixte. Après avoir décortiqué les casques et avoir abordé les cas d’usages généraux, cette fois on se penche plus précisément sur les casques passthrough.

On s’adresse toujours aux mêmes personnes, c’est-à-dire aux professionnels qui veulent utiliser la réalité mixte auprès de leur public pour des besoins variés : formation, visites augmentées, loisirs grand public, démarches commerciales, etc.

Ce qui va nous intéresser ici, c’est de savoir ce que valent concrètement ces casques et savoir s’ils sont adaptés à des opérations grand public.

Aujourd’hui l’offre peut se résumer ainsi :

- D’un côté les principaux acteurs du marché, Meta, HTC et Pico sont au coude à coude dans leurs offres, à quelques différences près qu’on expliquera ici.

- De l’autre, la marque Varjo se démarque en proposant des accessoires plus pointus.

Meta, Pico, HTC : même combat

Ces trois fabricants se font concurrence aujourd’hui avec des casques qui sont presque les mêmes sur bien des points. Jugez-en :- Leurs produits sont des casques d’abord conçus pour de la VR.

- Ils embarquent un mode passthrough qui est secondaire, mais qui devient pour les marques un argument à destination des professionnels. (On y reviendra)

- Les trois sont des casques autonomes. Ce qui signifie qu’ils sont utilisables sans branchement si on le souhaite. Ils conservent d’ailleurs les qualités d’autonomie de leurs anciens modèles, ce qui en font aujourd’hui des accessoires intéressants pour des démarches commerciales.

- Les trois intègrent du hand tracking et du face tracking dans un but d’interactions sociales immersives.

- Et enfin, les trois n’ont pas de capteur de profondeur, ce qui impacte la compréhension de l’espace (on y reviendra aussi).

Présentons-les brièvement

Des qualités techniques intéressantes, notamment un processeur 50% plus puissant que son prédécesseur (le Meta Quest 2).

Mais un prix relativement cher, 1799€ à sa sortie. 1199€ aujourd’hui.

Un passthrough très critiqué, quand bien même il offre un peu de relief car le casque calcule une image pour chaque œil. La profondeur est simulée, mais le rendu d’image est jugé moyen. Un test complet ici.

Casque de la société ByteDance, énorme acteur chinois du numérique, détenteur de TickTock.

Un prix plus abordable que ceux des concurrents : 900€

Un passthrough avec une meilleure qualité d’image, mais un rendu totalement plat. Pas de profondeur contrairement au Meta. Le casque embarque seulement une caméra RVB en façade qui voit le monde en 2D. Le mode passthrough est donc encore plus limité pour qui voudrait faire de la réalité augmentée.

Casque modulable, c’est son grand avantage ! On peut débrancher sa batterie à l’arrière (sans que le casque s’éteigne car il y a une autonomie temporaire) et transformer l’accessoire en casque ou en visière au choix.

Les systèmes d’eye tracking et de face tracking sont également des modules ajoutables séparément si on n’en n’a pas besoin. Le casque peut s’acheter sans.

Le HTC a le meilleur passthrough des trois casques. Chez lui les défauts de vision évoqués chez les concurrents sont atténués.

Le passthrough, une technique encore très limitée

Au fond, peu importe les petites différences entre ces casques. Ce qu’il faut retenir dans le cadre de cet article, c’est que leur passthrough est encore très limité.

Techniquement, il ne permet qu’une chose : conserver une vue du monde dans l’expérience VR, via le rendu caméra. Mais ce rendu a une qualité discutable.

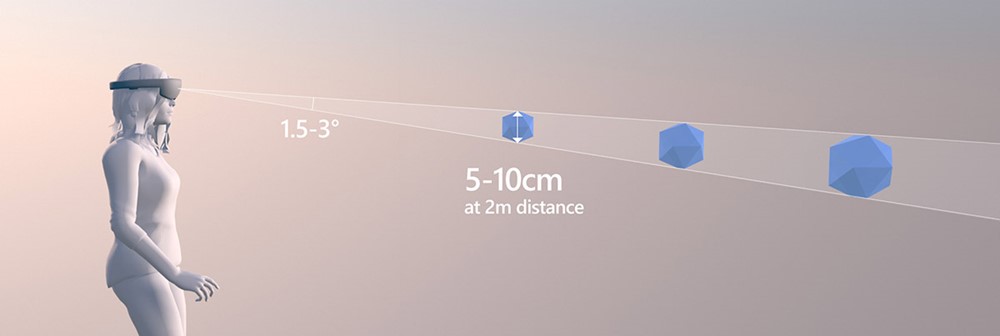

Mauvaise définition d’image, effets de distorsion en bordure, mauvais rendu de la profondeur, et donc difficulté de spatialisation et difficulté d’appréhender la distance et les objets. Certains articles ont très bien répertorié tous ces problèmes.

Bien sûr, nous insistons : ces problèmes ne concernent que les casques présentés ci-dessus. Il est fort probable qu’au moment où vous lirez ces lignes, d’autres casques soient sortis et aient amélioré cela.

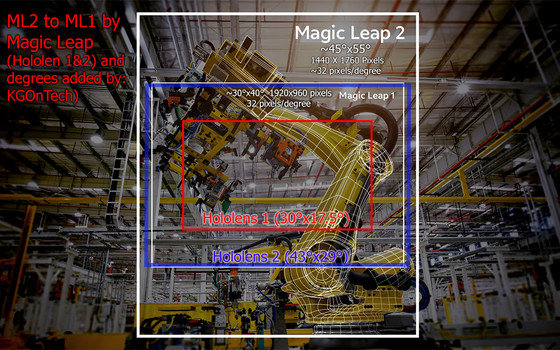

Tout cela pour souligner une chose : il ne faut pas envisager encore le passthrough de ces casques comme un outil de réalité mixte. Ce n’est pas ce qu’il est. Initialement, il n’est qu’un mode « vue réelle » ajouté à la VR pour éviter les accidents et gagner en confort d’expérience. Le but c’est de voir la pièce dans laquelle on est et de voir passer nos amis pendant qu’on joue à nos jeux VR. Pas vraiment de confondre le virtuel au réel, comme le font les casques Hololens.

Comprendre le monde sans capteur de profondeur

Une chose est souvent reprochée à ces casques, c’est l’absence de capteur de profondeur, soit la fameuse caméra « temps de vol » qui scanne l’espace en infrarouge. Si les trois fabricants ont décidé de ne pas en mettre, c’est qu’il y a des raisons. Sa présence impacte le prix et le poids, donc le confort.L’autre raison, plus intéressante, c’est que les fabricants peuvent s’en passer. Ils se servent des caméras existantes en façade qui leur offrent deux images distinctes. Couplées à des algorithmes de machine learning, elles permettent d’en tirer une information de profondeur. Un peu comme notre cerveau interprète la profondeur à l’aide de nos deux yeux, l’APK des casques fait de même avec les deux caméras.

Bien sûr c’est une profondeur qui est « devinée ». Elle est donc moins fiable qu’une information « mesurée » par une caméra Lidar. Dès lors, elle n’est pas suffisamment rigoureuse pour se reposer dessus. Mais ce n’est pas son but. Elle sert exclusivement un souci de confort. Sans profondeur, la navigation devient immédiatement plus difficile, voire cause de nausée pour les moins habitués.

Cette technique, c’est celle employée par Meta et HTC. Quant au Pico 4, on l’a dit, il n’a qu’une seule caméra en façade. Impossible pour lui d’obtenir du relief.

Ces casques s’adressent à des usagers bien précis

Si ces casques ne sont pas appropriés pour de la réalité augmentée poussée, c’est précisément parce qu’ils sont conçus pour autre chose.

Contrairement aux vrais casques XR qui cherchent à satisfaire des besoins métiers précis – entre autres dans l’industrie, le médical ou le militaire – les casques passthrough qu’on a cités sont pensés comme des accessoires homing et office.

Le côté « homing », on l’a déjà dit : c’est jouer aux jeux VR tout en continuant à regarder la télé, à parler à ses amis ou à pianoter sur son téléphone.

Quant à la partie « office », l’idée est de participer à des meetings avec ses collègues, aménager son bureau virtuel et profiter de ses applications de travail en réalité mixte.

C’est d’ailleurs un usage « working » qui est tout à fait nouveau. Il est apparu avec ces casques. On peut même dire sans exagérer que les fabricants ont simplement profité de petites améliorations du passthrough pour justifier des gammes « Pro », faisant ainsi passer le passthrough d’un simple mode de confort à un argument destiné aux professionnels pour leur vendre de la réalité mixte.

Pourtant rien n’a vraiment changé d’un casque à l’autre. Le Meta Quest 2 faisait du passthrough en noir et blanc. Le Quest Pro en fait en couleur. En dehors de ça, la technique reste la même.

Bien sûr, pour justifier le côté « Pro » des casques, les fabricants accompagnent le passthrough de plusieurs autres améliorations. Techniques d’abord, mais aussi des features business. On citera notamment les services Workplace de Meta et Business Suite de Pico qui offrent tous deux la possibilité de profiter d’une flotte de casques. C’est-à-dire, plusieurs casques connectés entre eux dans un même espace virtuel, utilisables ensemble, partageant les mises à jour et les contenus. Ce qui est un argument intéressant pour certains cas, comme la formation par exemple.

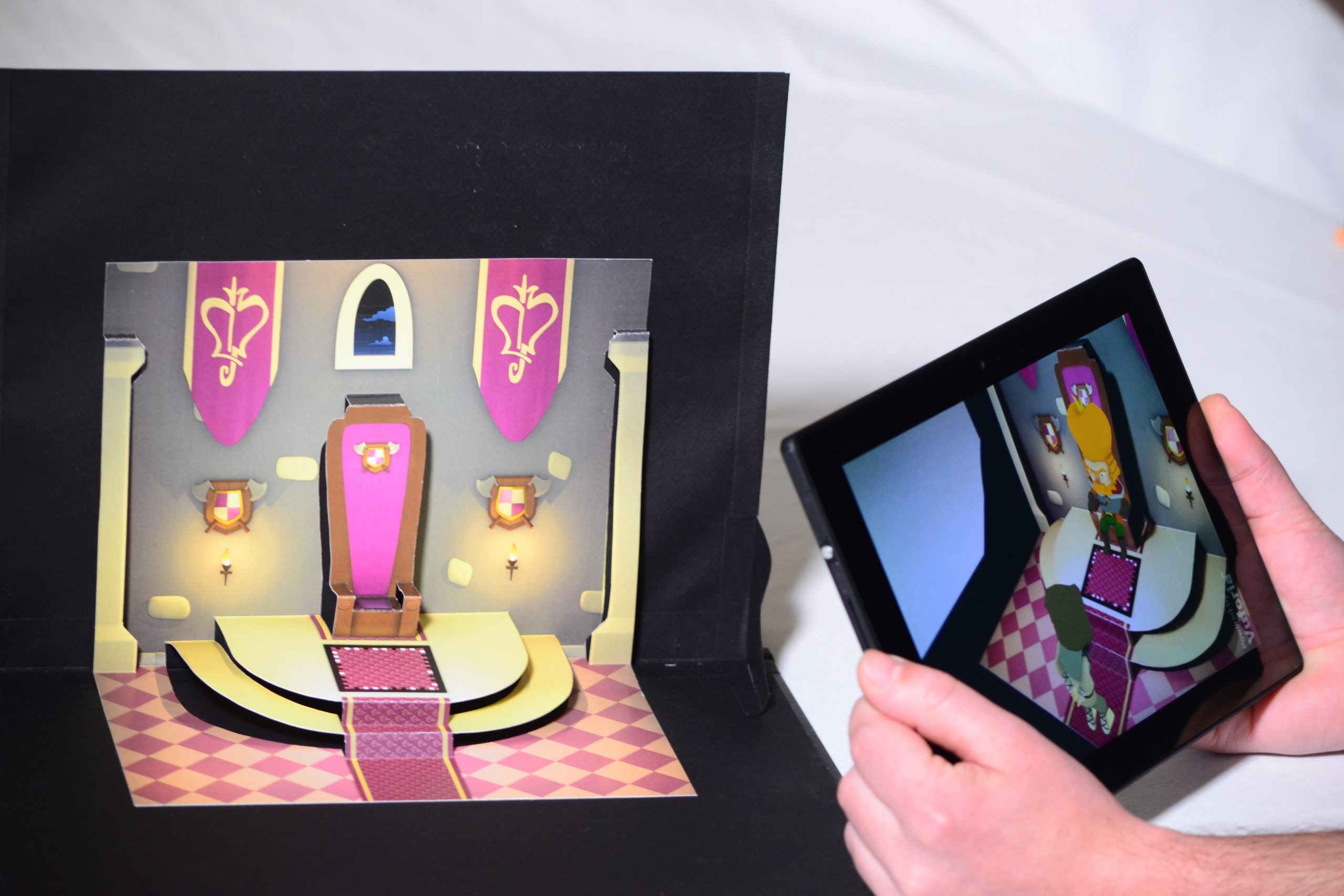

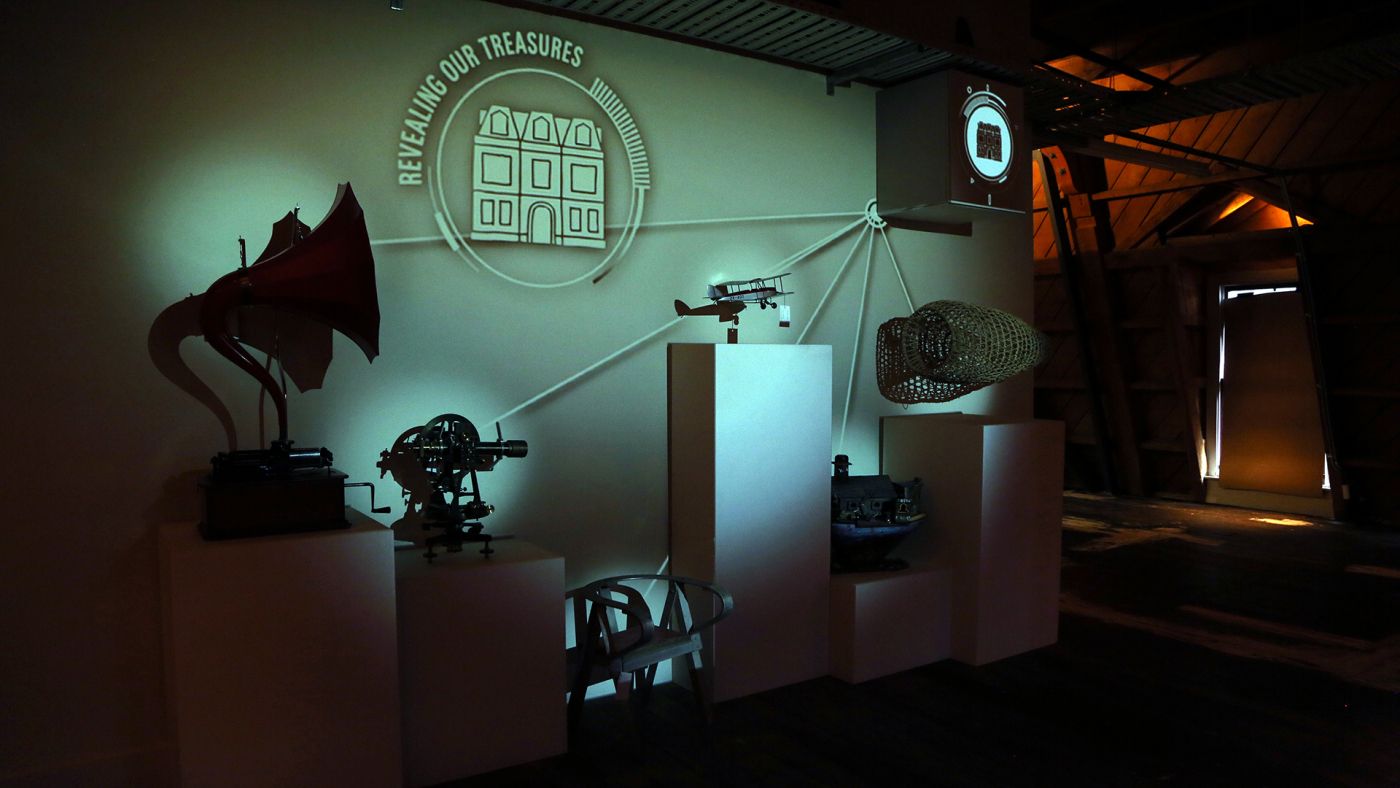

Quelques cas d’usages intéressants

(cliquez sur les noms des applications pour suivre les liens vidéo)

Les casques Varjo, le passthrough ultra-performant

Fondée en 2016 par des experts de Microsoft et Nokia, la marque Varjo s’est d’abord faite connaitre avec les VR-1 et le VR-2, deux casques de réalité virtuelle. Avec eux déjà, la marque misait sur l’ultra performance, devinant qu’il y avait un marché à prendre.

Leurs produits s’adressent uniquement aux professionnels qui ont besoin de pousser la technologie vers des usages inédits. En cela, ils sont davantage comparables à ceux d’Hololens. Même si les technologies ne sont pas les mêmes, le public cible et la stratégie commerciale le sont. Varjo concurrence Hololens et Magic Leap en passant par la méthode passthrough et en prouvant qu’elle a des vrais atouts à faire valoir.

Miser sur les meilleures technologies.

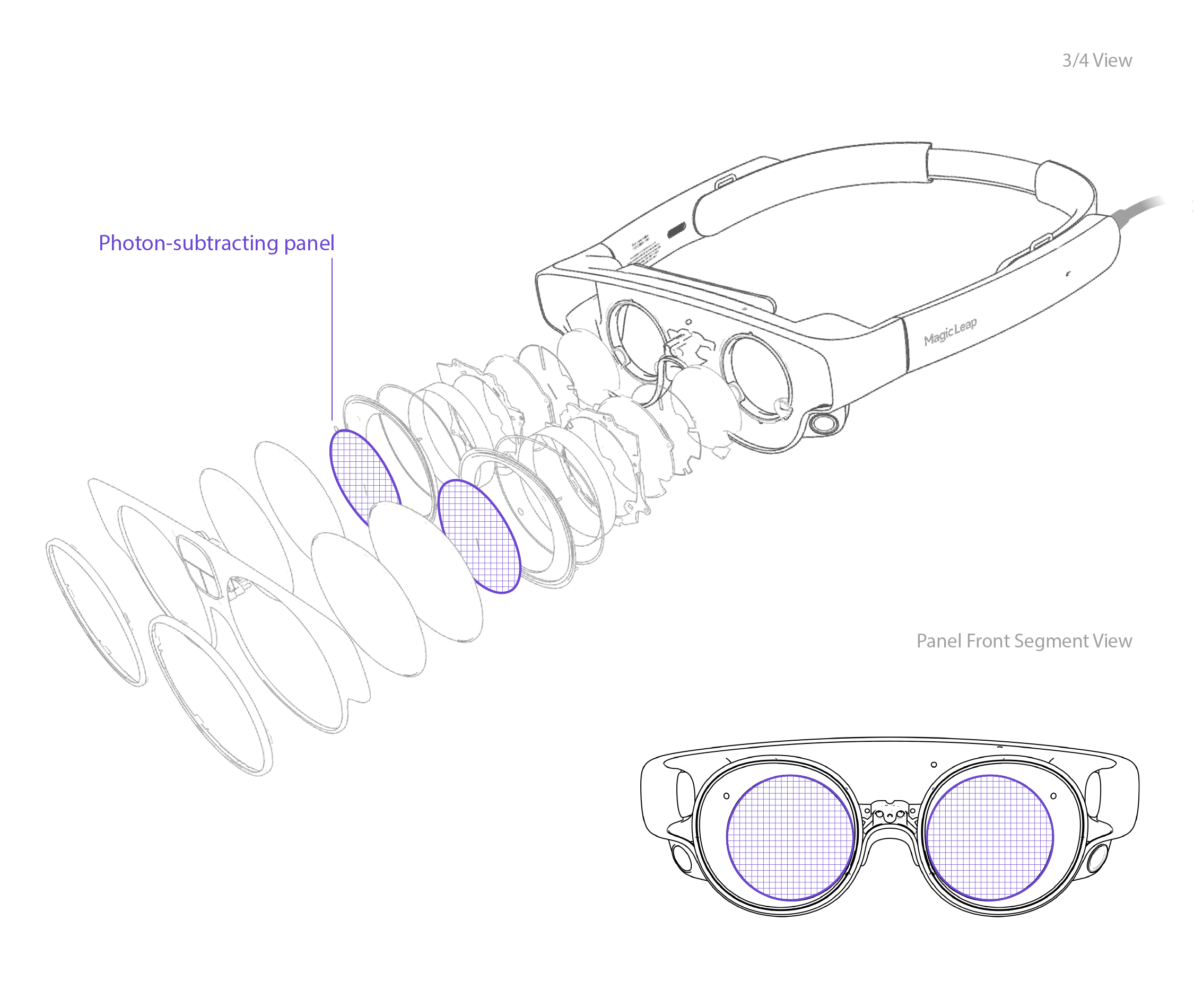

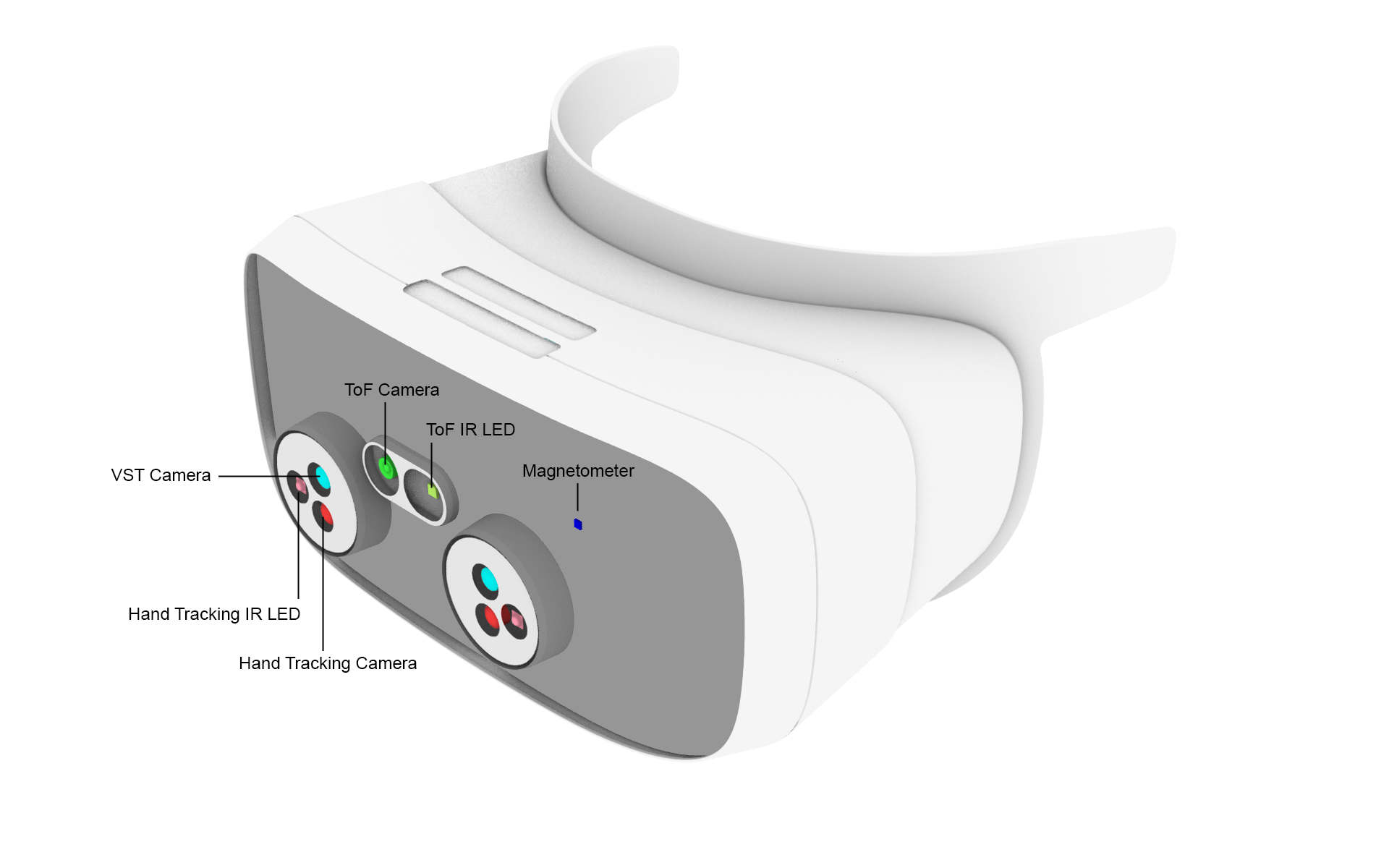

Le casque embarque un système Lidar lié à une APK capable de faire de la « reconstruction 3D ». Sorte de spatial mapping qui fusionne les données de profondeurs à d’autres informations pour servir dans la vue passthrough, à la fois pour la perception de profondeur et l’ancrage des hologrammes.

Cette qualité doit aussi beaucoup aux écrans atypiques du casque. Il en compte quatre. Deux par œil ! Un écran principal qui couvre l’ensemble du FOV et gère la vision périphérique, et un deuxième écran plus petit placé par-dessus. Ce deuxième écran fait toute la différence. Il permet d’afficher une image plus précise là où l’œil regarde (c’est le fameux rendu fovéal qu’on évoquait dans notre premier article).

Ce type de casque appelle un set-up bien précis.

On notera que pour alimenter ces écrans, deux câbles partent du casque et doivent être reliés à des prises électriques. Après tout, il s’agit d’embarquer un écran haut de gamme sur sa tête. Il faut donc l’alimenter.

Pour calculer le contenu, le casque doit aussi être relié à un PC haut de gamme. Varjo recommandent des configurations imposantes, avec cartes graphiques RTX 3080, voire A6000. (la performance pro).

Évidemment, être connecté à un PC empêche tout usage autonome. Le casque n’est pas pensé pour être transportable. Il appelle des démonstrations dans des espaces aménagés. Les cas d’usages sont donc bien particuliers.

Les cas d’usages : recherche, design, formation, simulation, …

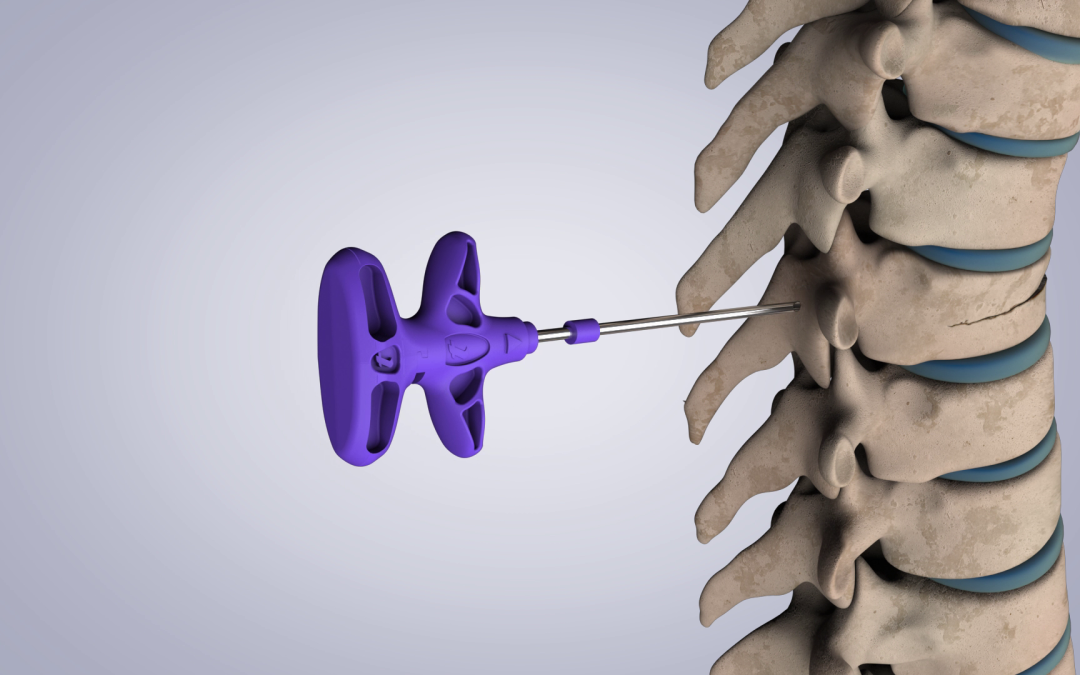

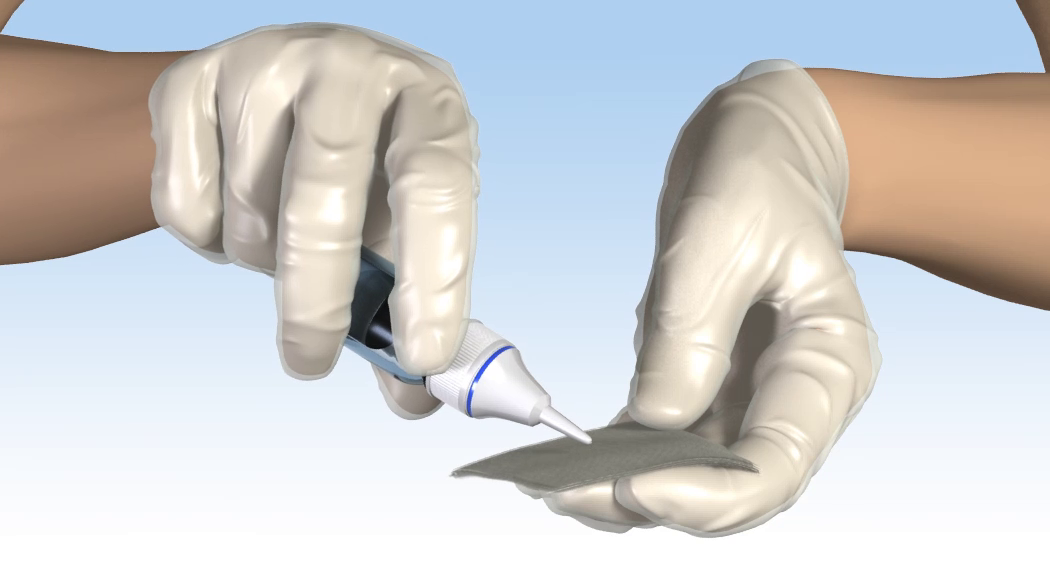

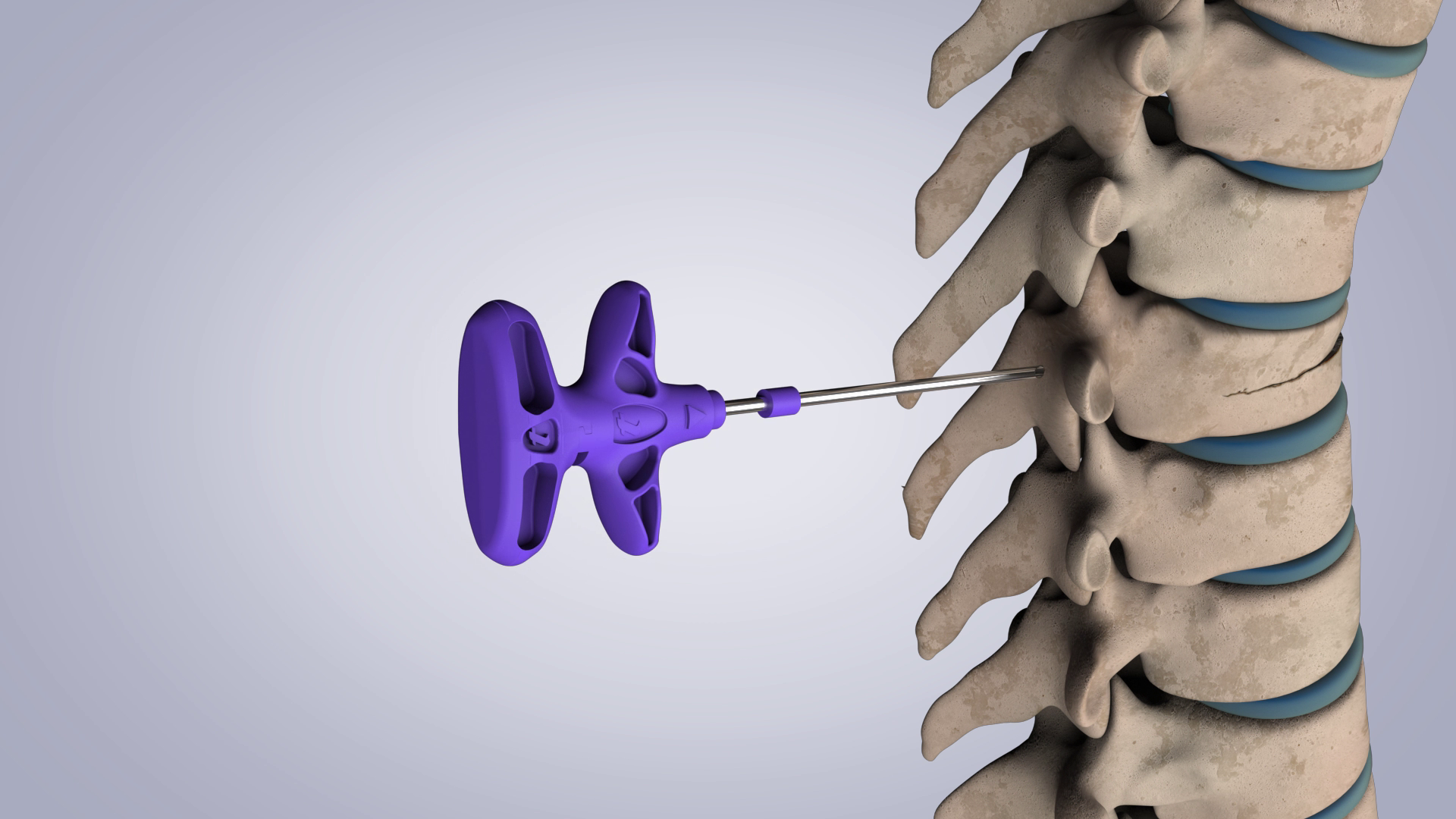

- La vue see-through (du monde réel) est très précise. Pas de flou, pas de perturbation. On peut lire un texte, manipuler des petits objets, pianoter des boutons. C’est probablement le plus gros défaut des autres casques passthrough, et la demande la plus exprimée par les professionnels. Celle de profiter d’une vue idéale pour mener des manipulations d’objets réels.

- Les éléments virtuels peuvent être en haute définition et graphiquement poussés. Là où des casques autonomes devront downgrader le contenu. On est donc assuré d’avoir des beaux modèles 3D augmentés et d’en mettre plein la vue à l’utilisateur. (bien sûr, on le répète, il faut une bonne config PC derrière).

- La superposition du virtuel est rendue plus précise et plus stable du fait du système de profondeur.

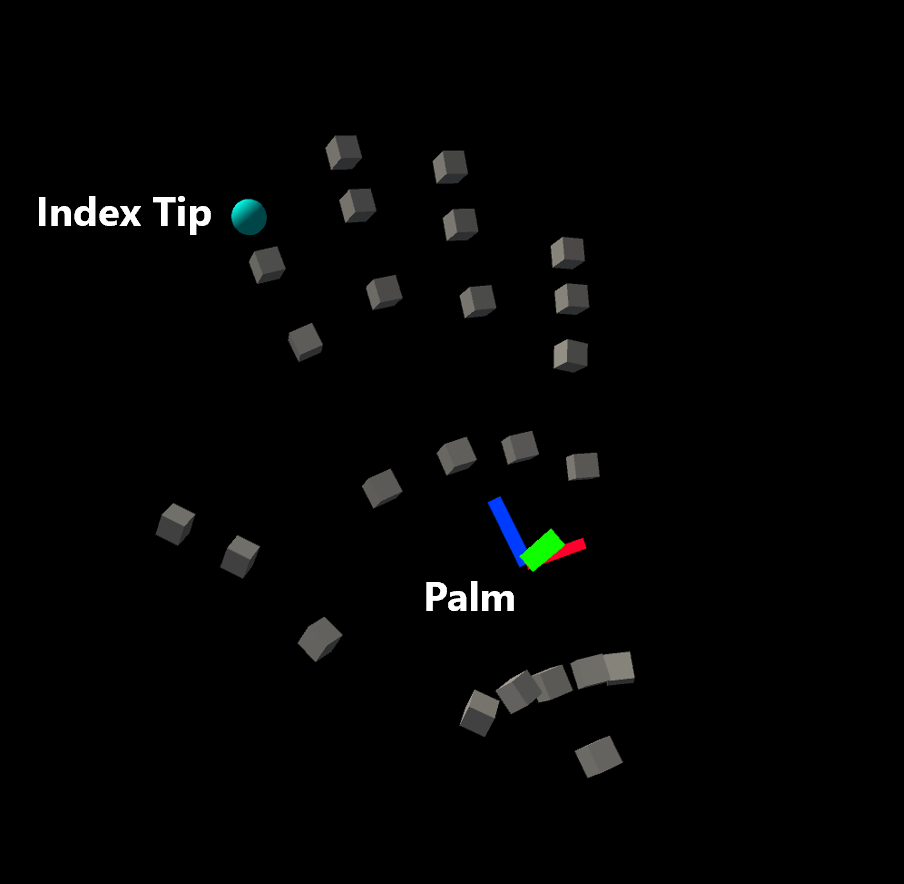

- Le hand tracking est très précis aussi, car il y a plus de caméras pour suivre les mains.