Les concepts de réalité augmentée

Les concepts de réalité augmentée

Le terme de Réalité Augmentée — ou son diminutif RA ou AR à l’anglaise — est fréquemment utilisé pour désigner une application permettant de visualiser un objet virtuel, ce dernier étant positionné sur la surface que l’on est entrain de regarder, au travers de son smartphone.

Je préfère en effet le terme « concept » à « technologie », car la réalité augmentée n’est pas UNE technologie, mais plutôt la convergence de multiples technologies logicielles et matérielles associées pour enrichir notre vision du réel.

Risquons-nous à une définition :

« La réalité augmentée désigne des méthodes numériques permettant d’ajouter à notre perception du réel, une surcouche d’information contextuelle, en temps réel. »

Avec cette définition, on constate combien les limites sont floues.

Est-ce qu’un affichage de la vitesse d’une voiture sur le pare-brise est de la réalité augmentée ?

J’aurai tendance à dire non, car si en s’affichant sur le pare-brise, elle se superpose bien au réel, elle n’est pas issue de ce que voit le conducteur. Mais on pourrait dire que oui. C’est de la RA au stade embryonnaire, dans la mesure où on diffuse bien une information issue du réel : la vitesse de la voiture.

Cela dépend de l’interprétation.

En revanche, dès que le système va mesurer et afficher la distance du véhicule devant vous, il n’y a plus de doutes, nous sommes en présence de réalité augmentée. #RA-automobile

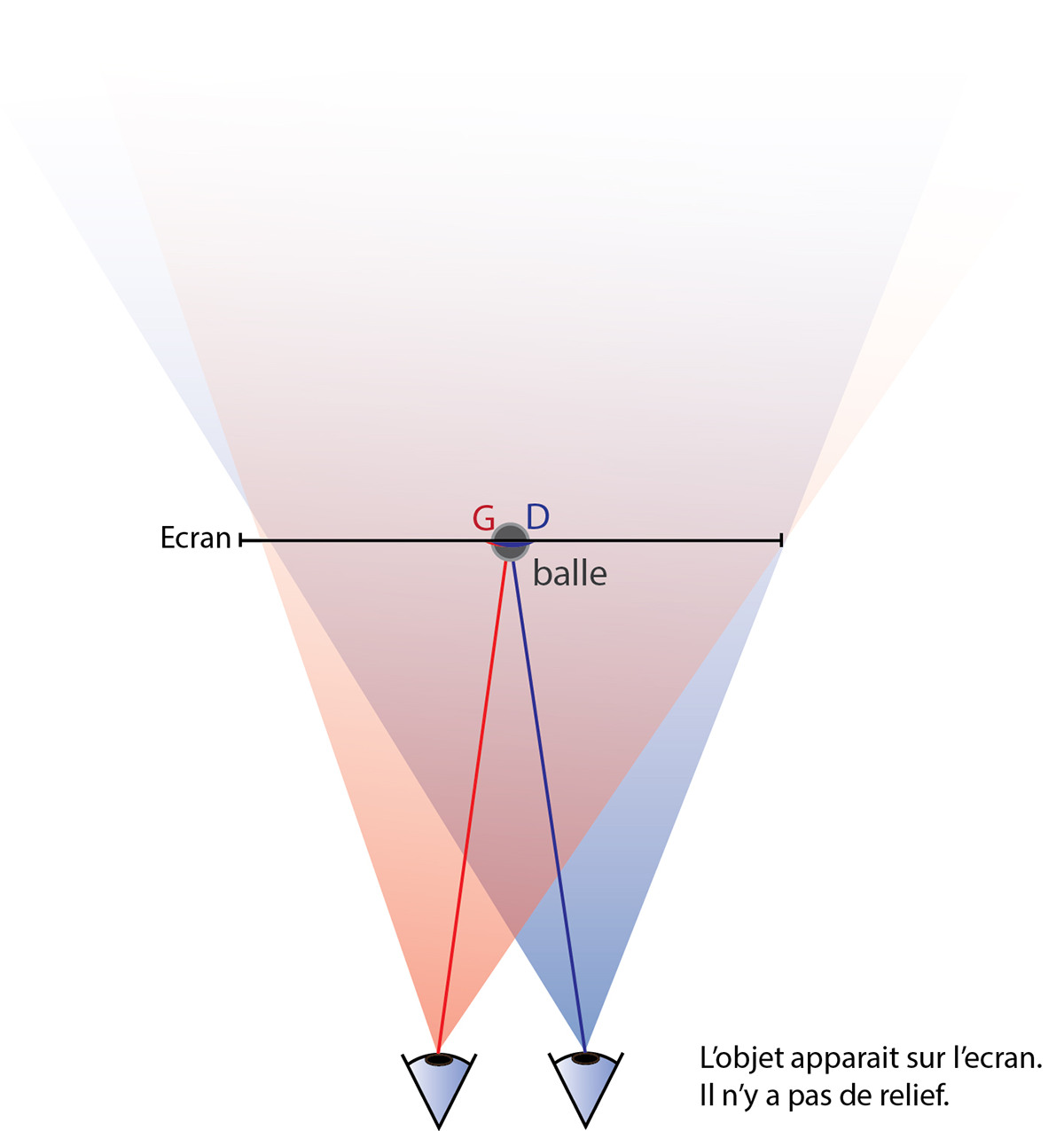

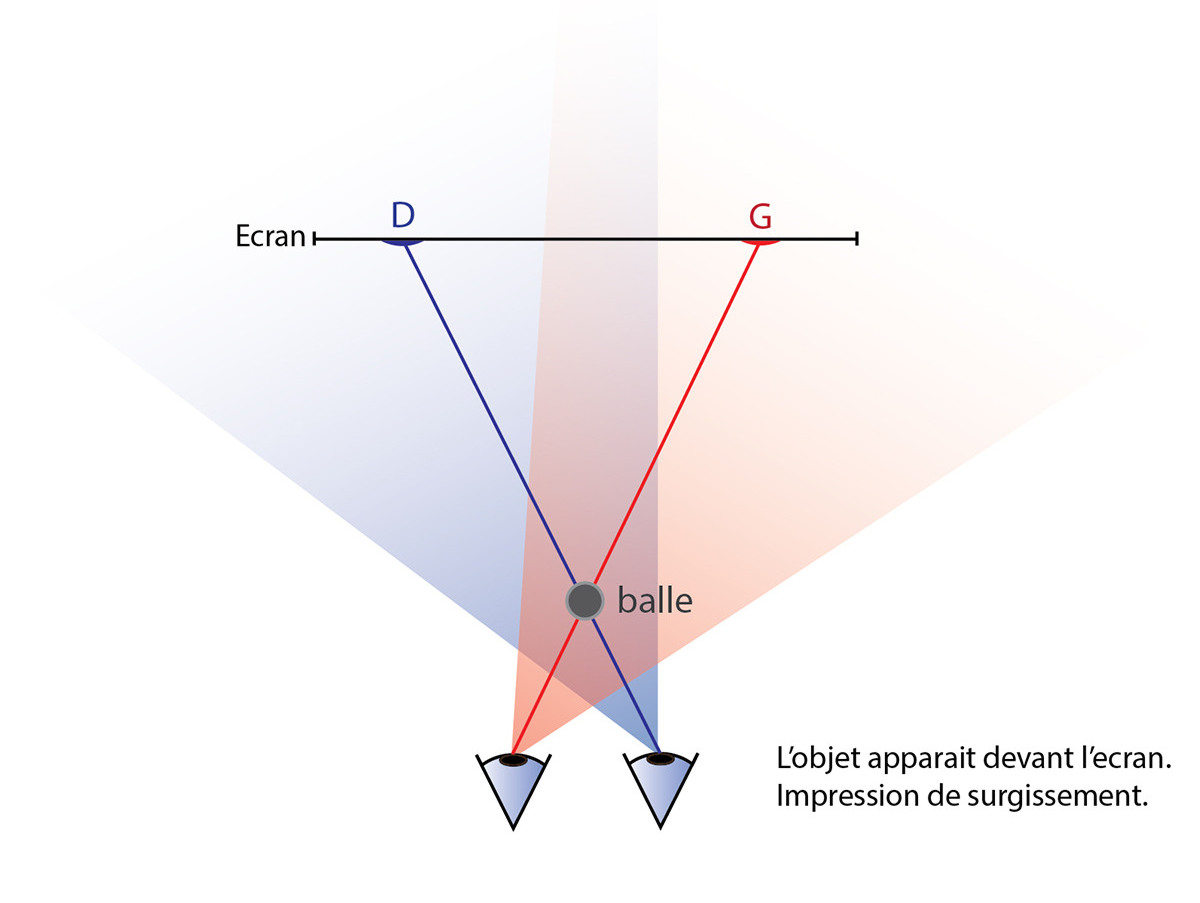

Il faut bien noter la différence : avec la réalité augmentée, les utilisateurs restent en contact avec le monde réel, alors que la réalité virtuelle a pour objectif de les transporter ailleurs, dans un autre lieu.

Cet amalgame vient certainement du fait que l’on peut diffuser des objets virtuels via la réalité augmentée.

Sa force : enrichir par de l’information !

Nous, êtres humains, sommes dotés de 5 sens pour percevoir notre environnement. Si nous voulons « l’augmenter », il faut parvenir à enrichir cette perception par de l’information complémentaire. Voire la rendre interactive.

Pour l’odorat, le goût et le toucher, il est difficile de les agrémenter, faute de technologies et d’idées. Certains projets entrouvrent quelques portes pour des applications aux possibilités enivrantes : un groupe de recherche de l’UEC Tokyo (The University of Electrocommunications) a élaboré une surface interactive, baptisé « ClaytricSurface », dont la souplesse peut être ajustée à la demande. Mais pour le grand public, il faudra encore patienter un petit peu.

Pour l’ouïe, on note l’utilisation d’audioguides. Un outil très efficace pour compléter la visite d’un musée. Ils permettent d’enrichir l’information textuelle par une description orale, à la demande, qui peut être dans la langue du visiteur.

C’est là une des premières formes de réalité augmentée : simple et efficace.

Mais les évolutions de la réalité augmentée sont poussées par toutes les nouvelles technologies. Au travers de la vision numérique de l’utilisateur, il devient possible de lui diffuser de l’information.

- textuelles pour de la description ou de la légende

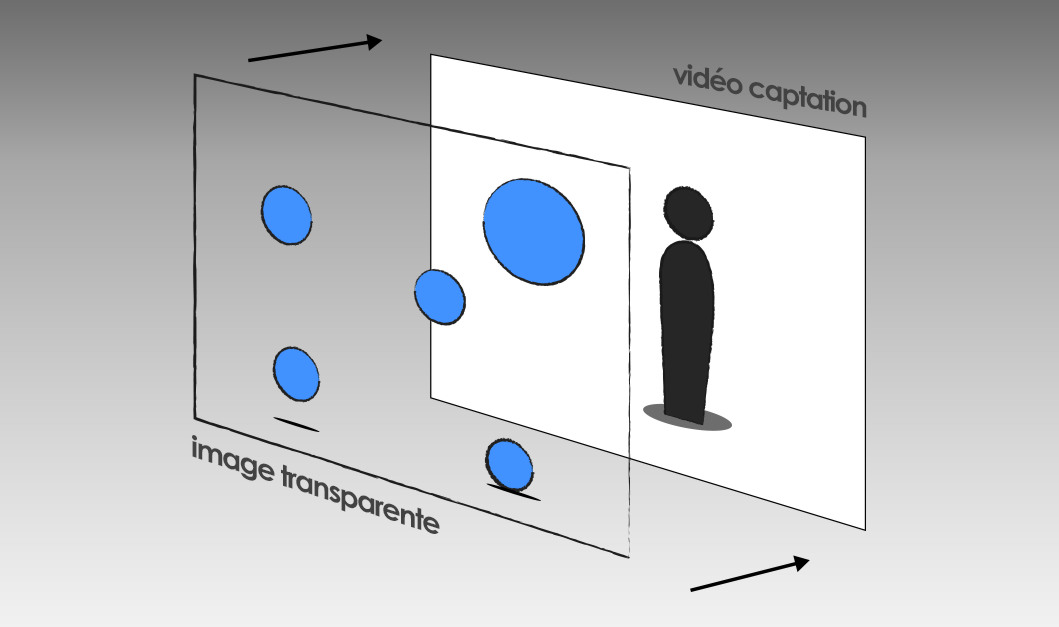

- en image 2D comme de la photographie, du schéma, de l’image de synthèse

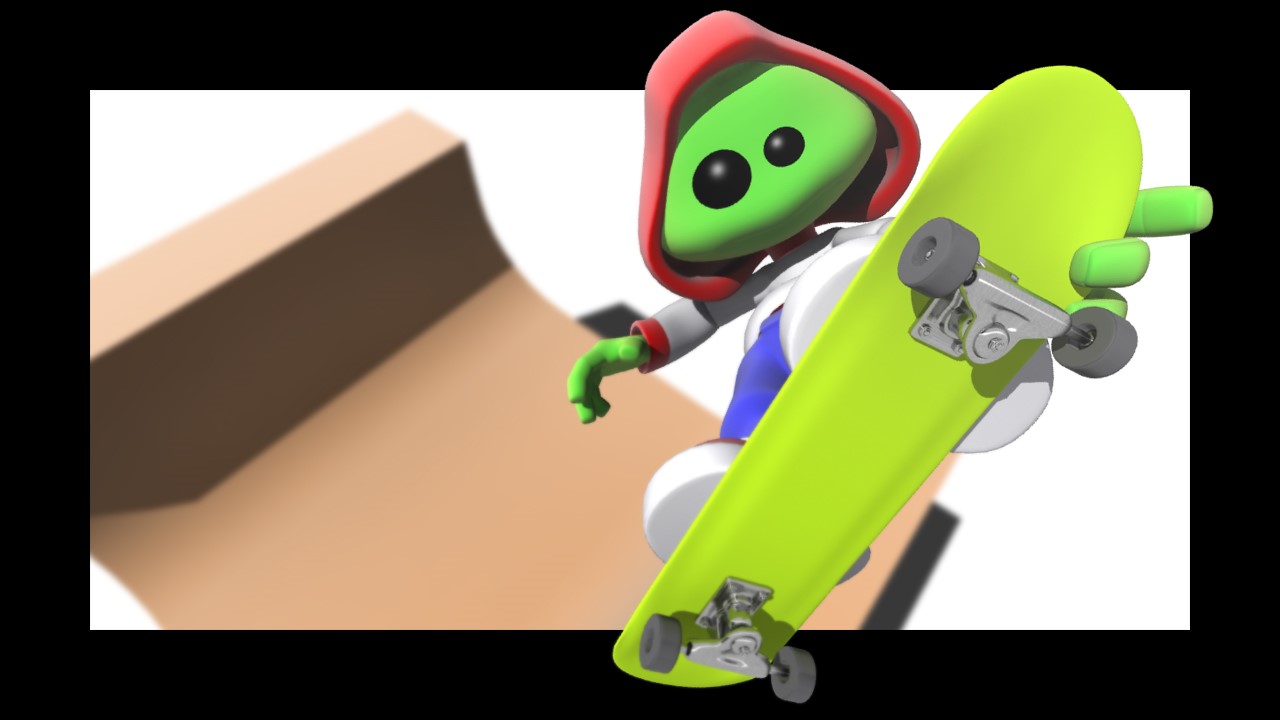

- un objet ou une scène virtuelle 3D, qui vient s’intégrer dans l’espace réel.

Mais le plus important et le plus intéressant : ces informations « s’accrochent » à la réalité, en se fixant et en suivant les mouvements des objets que l’on observe au travers de notre regard numérique.

Une technologie futuriste ?

Catégoriquement non.

Les technologies utilisées pour mettre en œuvre une application en RA ne datent pas d’hier. Elles sont élaborées et affinées depuis deux bonnes décennies.

Le seul facteur qui la rend clairement accessible et exploitable maintenant, c’est la démocratisation des smartphones et des tablettes, petits bijoux de technologie à la puissance somme toute considérable.

Ils sont connectés. Ils intègrent de nombreux capteurs nous renseignant sur l’environnement réel de l’utilisateur : caméra haute définition, GPS, gyromètre, magnétomètre, gravitomètre, etc. ; et enfin, ils sont en mesure de diffuser l’information.

De ce seul appareil, nous pouvons obtenir le nécessaire pour bâtir les 3 piliers de la RA.

Les 3 piliers de la RA.

Je ne reviendrai pas sur le premier : l’information. Votre information : technique, didactique, divertissante, publicitaire, votre produit, votre scène, l’ensemble de vos médias à diffuser.

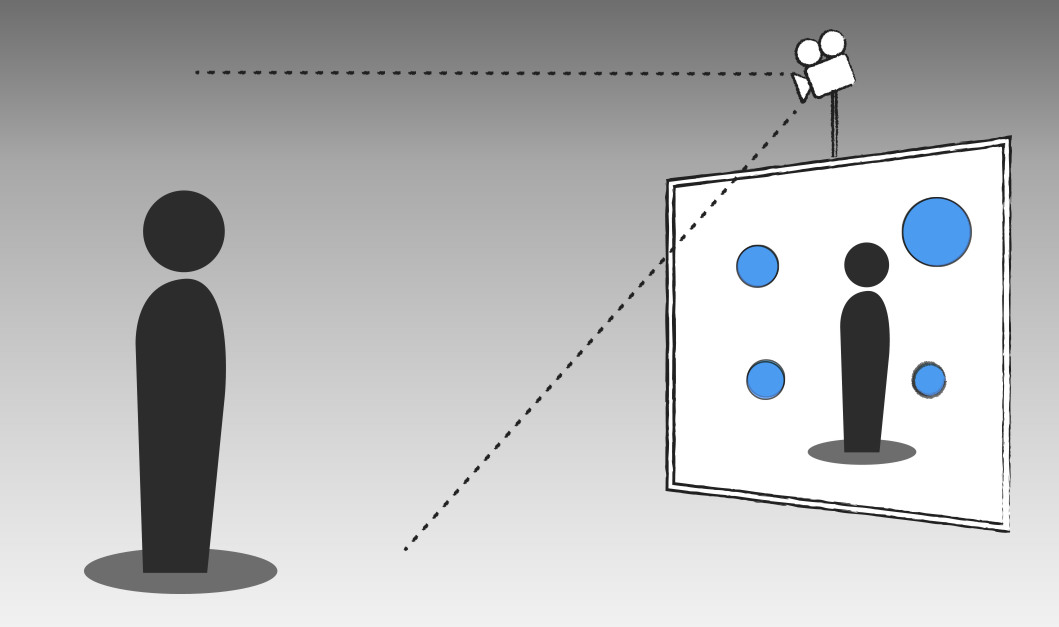

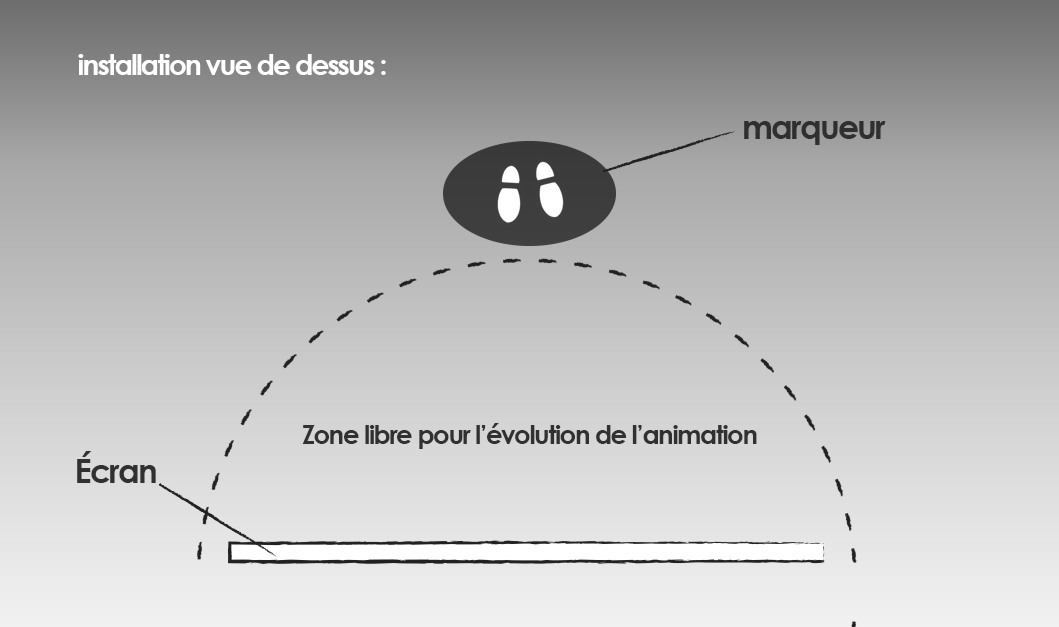

Le deuxième est le moyen de diffusion. Aujourd’hui, c’est majoritairement — pour les raisons que je viens d’évoquer — l’écran du smartphone.

Mais cela peut être également par projection, ou alors par diffusion sur une plaque de verre.

Enfin, le dernier pilier, le sujet de nos préoccupations, l’utilisateur. On veut connaître son contexte, sa situation, éventuellement son profil dans le cas d’une application commerciale. C’est le contexte qui va permettre de proposer et d’afficher l’information de manière optimale, filtrée. Filtrée en fonction de ce que regarde l’utilisateur si on considère le point de vue.

Pour tout nouveau projet de création d’une application RA, une analyse basée sur ces 3 piliers permet d’en définir les contours précis et de mettre en place un cahier des charges.

Les utilisations courantes de la réalité augmentée.

Le fait que presque tout le monde possède un smartphone dans sa poche et l’émergence d’outils de développement accessibles, orientés réalité augmentée, ont privilégié l’approche visuelle de la réalité augmentée.

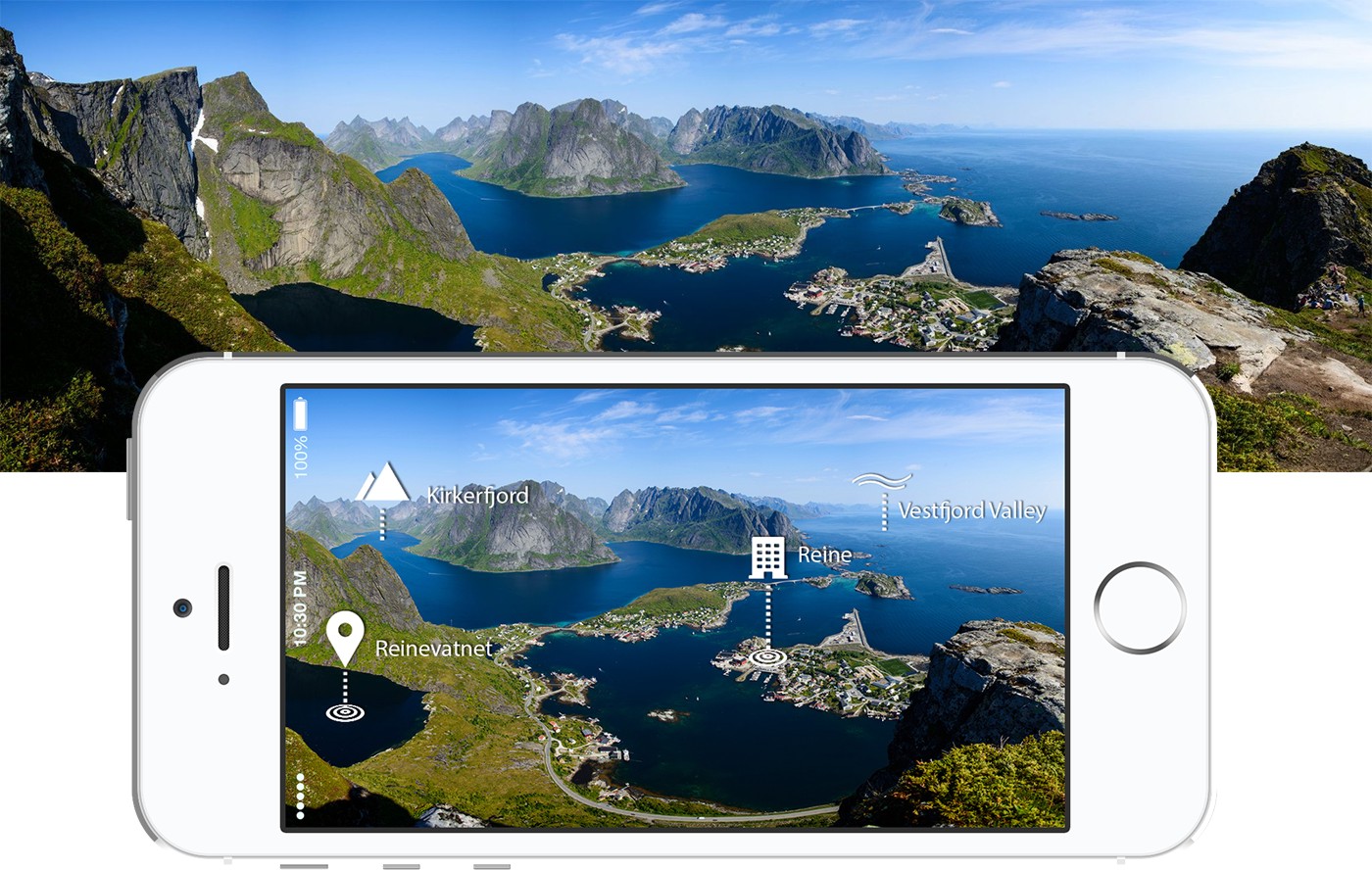

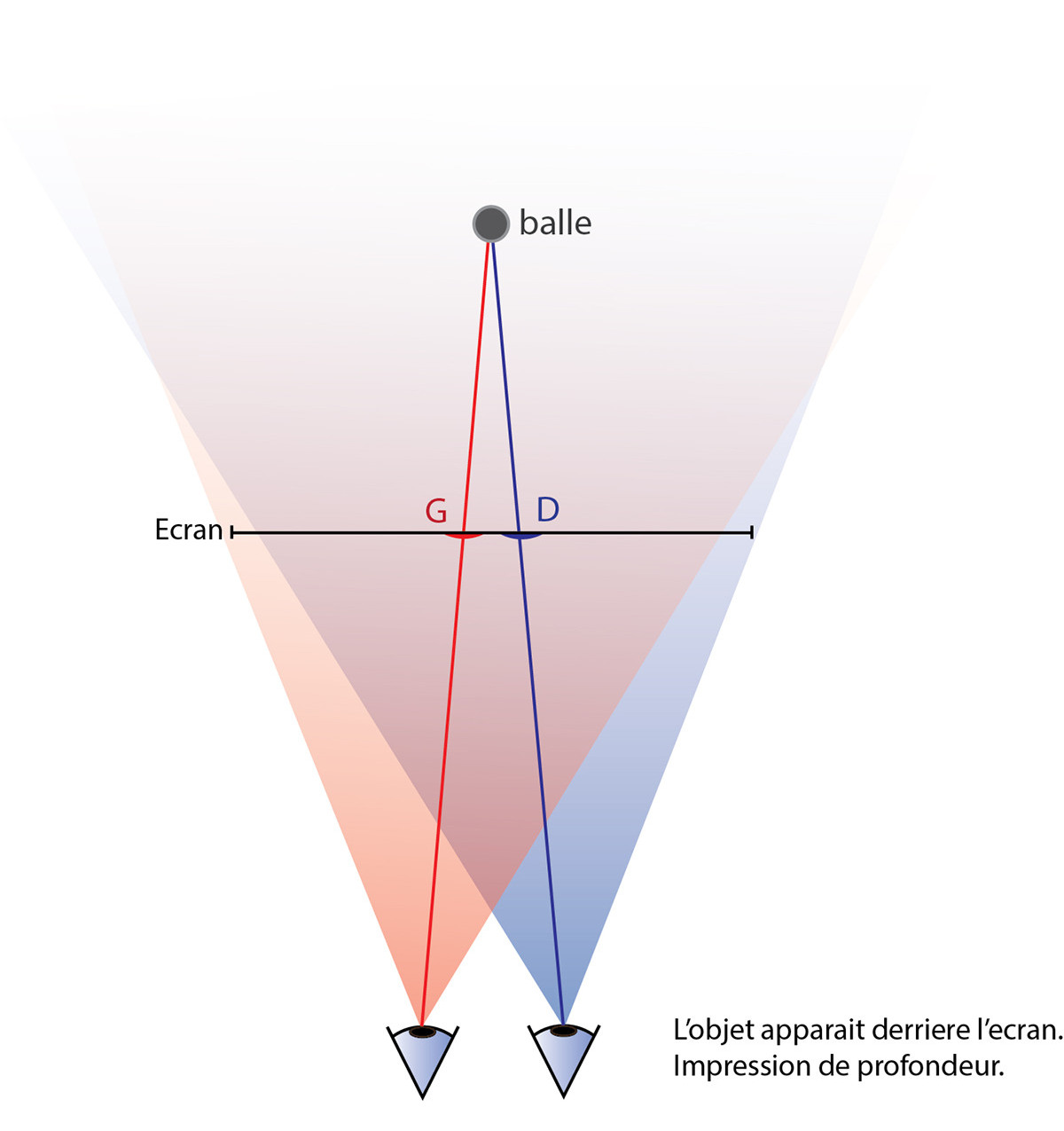

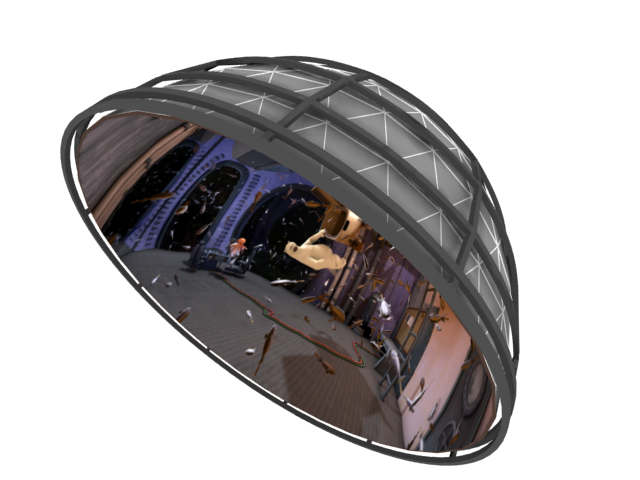

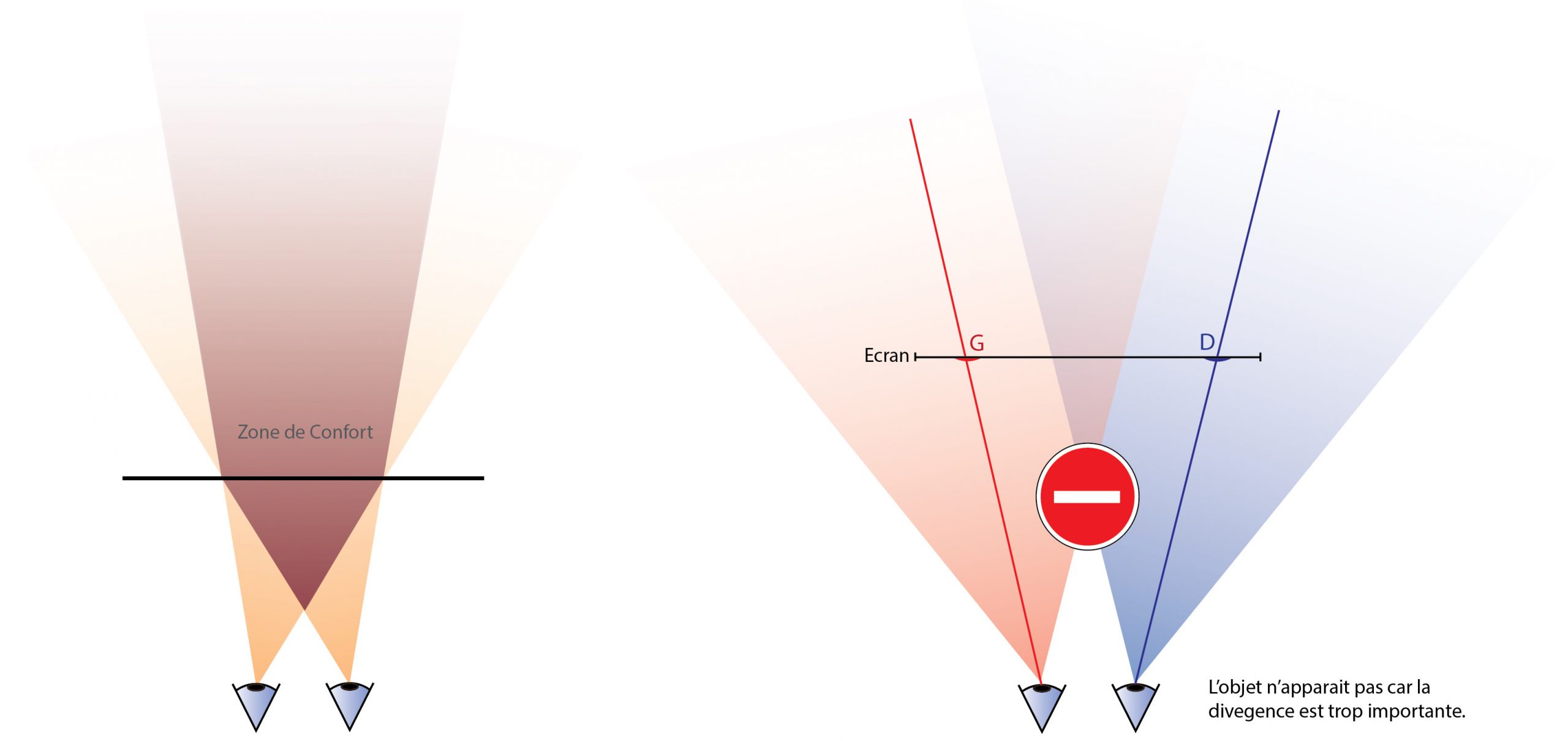

Pour les applications de réalité augmentée panoramique, nous avons besoin de connaître où le spectateur se situe, et dans quelle direction pointe son observation. À l’aide du GPS — ou autres systèmes nous permettant de trianguler sa position —, on le géolocalise, et avec les capteurs d’orientations, nous avons suffisamment d’informations pour enrichir le panorama qui est devant lui : RA panoramique.

La plus-value de la réalité augmentée.

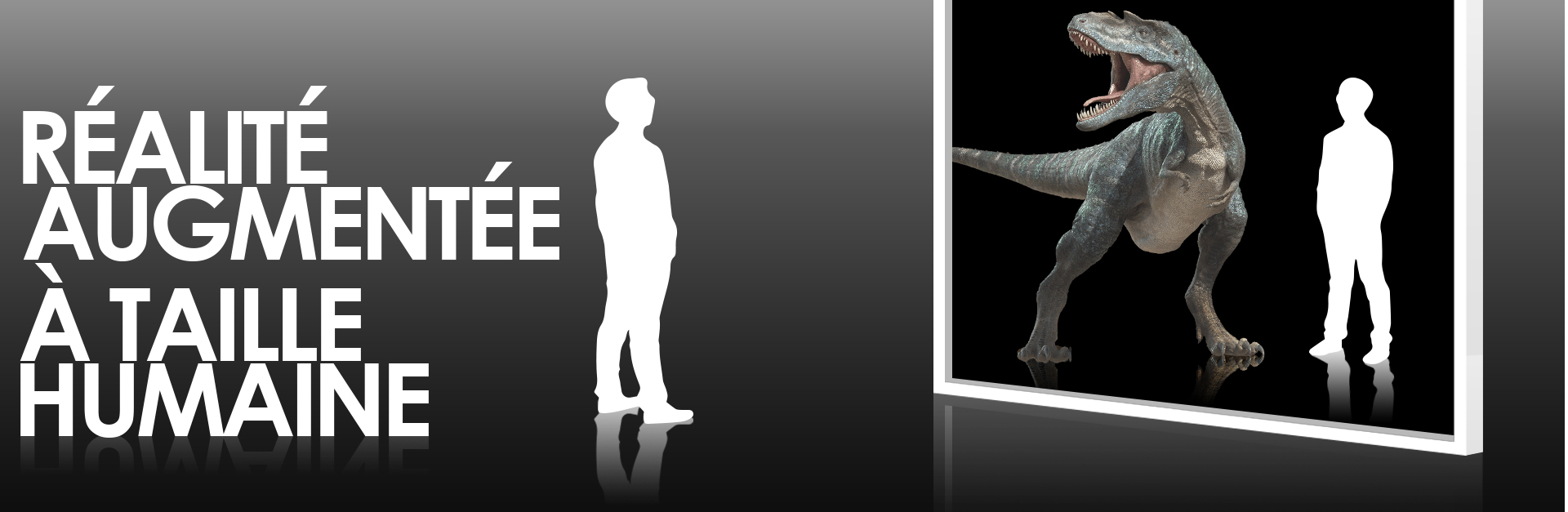

À l’heure actuelle, la majorité des applications en réalité augmentée ont une approche ludique. Parce qu’elles attisent la curiosité et qu’elles sont simples à pratiquer, elles sont beaucoup utilisées lors d’opération événementielle — salon ou streetmarketing — et elles profitent d’une seconde vie audelà de l’événement.

Ceci est profitable d’un point de vue marketing et optimise l’investissement, car le shopper reste plus longtemps en contact avec le produit ou la marque, et partage facilement l’expérience avec son entourage.

Dans ce contexte, il est préférable d’assumer son côté divertissant sans prétendre à une application « pratique ». C’est par ce biais qu’Ikea, en mon sens, a bien abordé en vidéo sa communication autour de son application :

Par l’exploitation de la réalité augmentée, une entreprise se positionne, au moins dans sa communication, dans l’innovation numérique, auprès d’un large public : la fameuse génération Y qui a largement dépassé la vingtaine — … soupir…

Si la réalité augmentée permet encore aujourd’hui de se différencier, cela ne durera pas, du moins pas dans cette approche ludique.

De même que le web, les choses évoluent rapidement avec la RA. La société d’étude et de consulting Jupiner Research évalue son marché actuel à $247 millions en 2014, pour un marché en 2019 estimé à environ $2,4 milliards.

On l’aide ainsi à se projeter avec le produit et on l’incite par cette démarche à s’impliquer dans cette intégration — et j’ose souffler : acquisition.

Alors, l’interaction avec l’objet devient plus naturelle, car on tourne réellement autour. Plus besoin de souris, de clavier et de poste fixe. Il ne reste plus que l’écran du smartphone ou de la tablette.

Je réitère mon avertissement, ces casques ne sont pas à confondre avec des casques de réalité virtuelle comme le Samsung Gear ou l’Oculus, qui, même s’ils sont technologiquement proches, nous coupent de la réalité et nous projettent dans un monde virtuel.

Reste enfin la plusvalue « service » dans des applications utiles, qui ne se limitent pas à de la présentation, mais qui sont une aide pour l’utilisateur. De l’application « légère » pour la découpe d’un gâteau en X parts, au choix de la bonne taille du carton d’emballage en fonction du volume de son envoi, en passant sur des informations temps réel de son environnement proche. À l’instar des applications smartphones, les applications offrant un réel service ont les plus grands succès.

Cette réflexion plus « pratique » de la RA, associée aux possibilités « mains libres » des casques de RA, ouvre un vaste champ d’applications dans de nombreux domaines : l’éducation, la formation ou tout simplement le travail de tous les jours :

Imaginer un tutoriel pour changer une roue de voiture, où la procédure s’affiche directement sur et autour de la roue. OK, trop simple, alors pour le corps humain ?

#ChirurgieVirtuelle

La réalité augmentée en est à ses balbutiements et tout reste à inventer, comme l’était internet dans les années 90.

Imagination — prêt — partez !